Що таке GCP та як ви можете використовувати його для свого бізнесу

Google Cloud Next 2025: Вся увага на штучний інтелект

- Штучний інтелект та мультиагентні системи

- Інфраструктура штучного інтелекту

- Розробка застосунків

- Cloud Run та SaaS Runtime

- Обчислення

- Контейнери та Kubernetes

- Клієнти

- Бази даних

- Аналітика даних

- Google Workspace: Продуктивність на основі штучного інтелекту

- Робота в мережі

- Безпека

- Сховище

- Стартапи

- Про нас

На Google Cloud Next 2025 було понад 10 ключових доповідей і сесій, а також 700 поглиблених презентацій. Захід був насиченим, охопив усі аспекти інновацій і дав чітке уявлення про найновіші доповнення та стратегічний фокус Google Cloud.

Тепер, коли ми мали змогу ввібрати в себе все та трохи часу на роздуми, давайте детальніше розглянемо кожну ключову сферу та виділимо найвпливовіші анонси Google Cloud Next ’25.

Штучний інтелект та мультиагентні системи

Завдяки публічній попередній версії Gemini 2.5 Pro, яка наразі очолює рейтинг Chatbot Arena, та майбутній версії Gemini 2.5 Flash, яка створена для швидкості та ефективності, більше людей отримали доступ до потужних інструментів для розмірковувань та кодингу.

Крім того, Google Cloud зробив Vertex AI єдиною гіперскейлерною платформою, що пропонує генеративні медіа-моделі для відео, зображень, аудіо та музики. Це стало можливим завдяки Imagen 3, Chirp 3, Lyria і Veo 2, а також Llama 4 від Meta (тепер загальнодоступній) і новому партнерству з Ai2.

Чому це важливо: Це позиціонує Vertex AI як першокласну платформу для створення мультимодальних ШІ-застосунків. Розробники та компанії отримують неперевершений набір опцій та інструментів для роботи з широким спектром типів даних — те, що чітко виділяє Google Cloud у просторі штучного інтелекту.

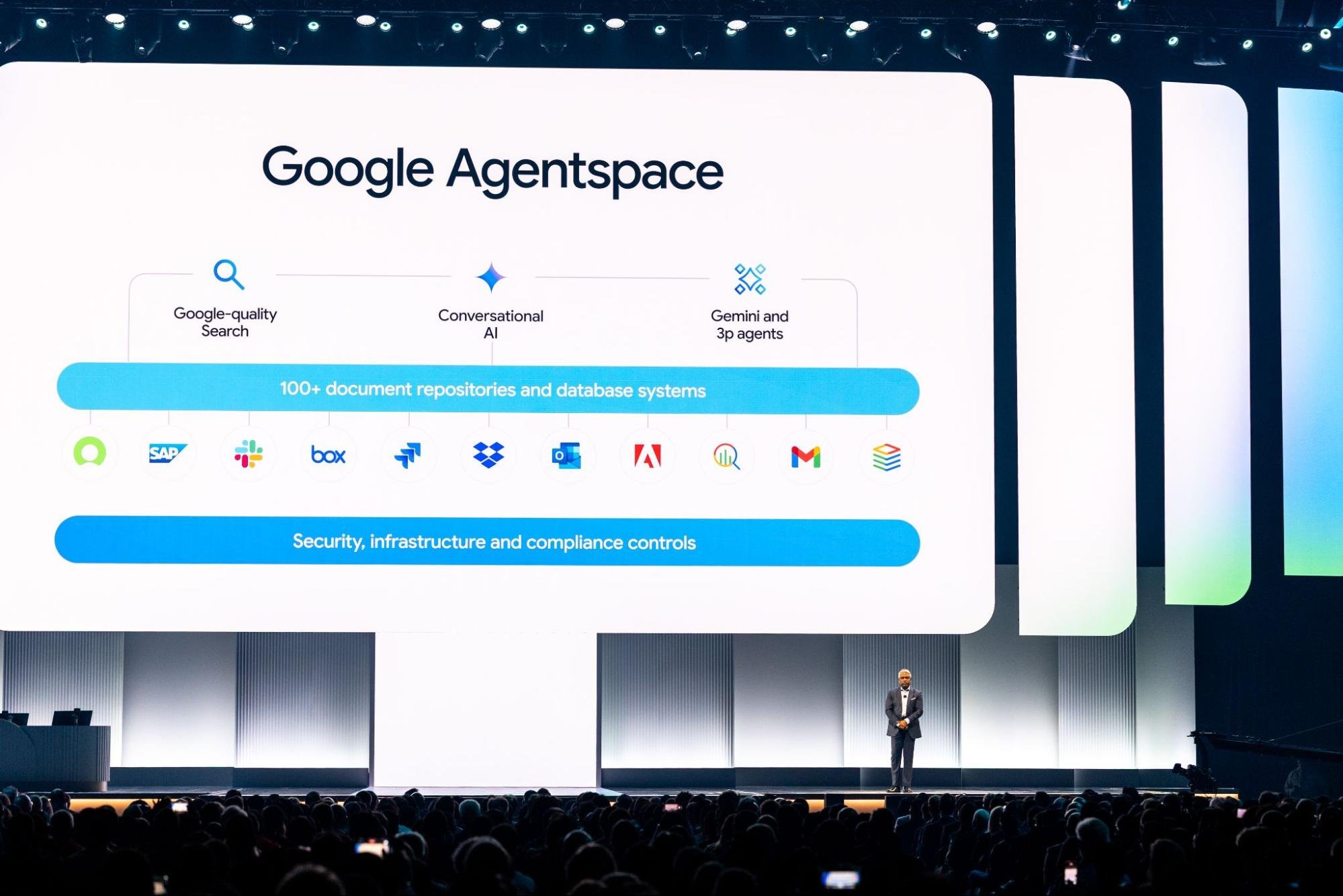

Google Cloud також представив Agent Development Kit (ADK) та відкритий протокол Agent2Agent (A2A), який вже має підтримку десятків партнерів. Ці інструменти закладають основу для побудови та управління складними системами взаємодіючих агентів ШІ.

Новий Agent Engine додає повністю кероване середовище для тестування та розгортання цих систем у великих масштабах. Такі інструменти, як Agentspace — що тепер підключений до Chrome Enterprise — разом із Agent Gallery та No-Code Designer, створені, щоб допомогти компаніям впроваджувати ШІ-агентів у командах і відділах, передаючи можливості штучного інтелекту в руки звичайних користувачів.

Чому це важливо: Це знаменує чіткий зсув у бік допомоги бізнесу не лише у вивченні ШІ, але й у його застосуванні на практиці. Відкриті стандарти залучають спільноту, а керовані сервіси та зручні інструменти знижують бар’єр для входу. Це означає, що все більше організацій можуть використовувати штучний інтелект для високоефективної роботи, такої як дослідження, стратегія та інновації, не потребуючи для цього команди інженерів.

Джерело: cloud.google.com

Інфраструктура штучного інтелекту

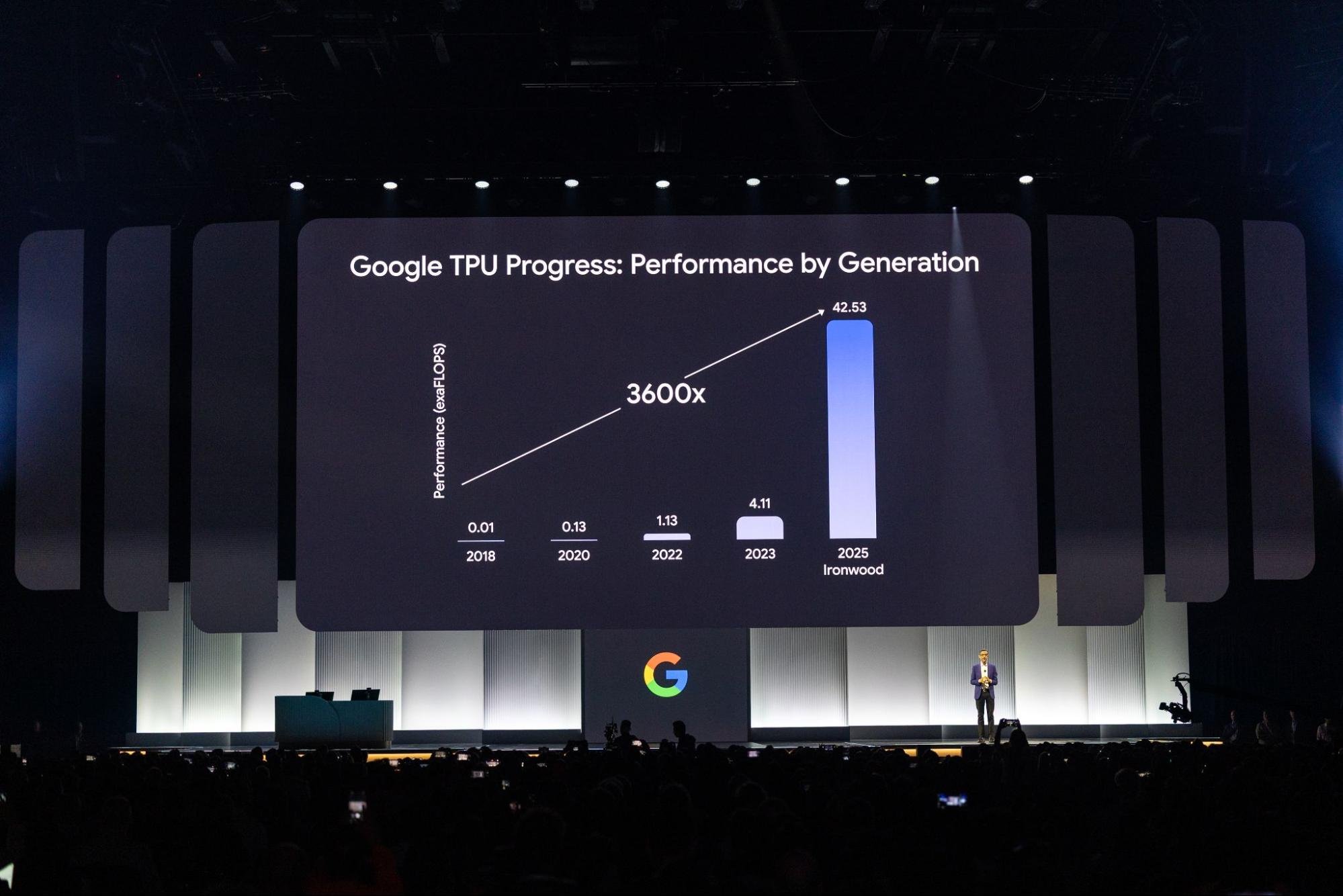

Майбутній Ironwood (TPU 7-го покоління від Google) та запуск віртуальних машин A4 та A4X на базі графічних процесорів NVIDIA Blackwell (B200 та GB200) демонструють прагнення Google Cloud залишатися в авангарді апаратних інновацій у сфері ШІ.

Google Cloud був першим великим постачальником, який запропонував графічні процесори Blackwell, і вже збирається стати одним із перших, хто запропонує чипи NVIDIA Vera Rubin. Уперше клієнти також отримали доступ до Pathways on Cloud, розподіленого середовища виконання DeepMind, створеного для роботи з великими та складними моделями штучного інтелекту.

Чому це важливо: Ці оновлення надають користувачам величезну обчислювальну потужність та ефективність для навчання та запуску великомасштабних моделей. Це дуже важливо, оскільки попит на серйозні потужності ШІ зростає. А завдяки ранньому виходу на ринок з графічними процесорами NVIDIA найвищого рівня, Google Cloud додає ключову перевагу для клієнтів, яким потрібні високопродуктивні системи зараз, а не пізніше.

Google Distributed Cloud (GDC) співпрацює з NVIDIA, щоб перенести моделі Gemini в системи на базі Blackwell, в тому числі і в локальні середовища. Cluster Director (раніше відомий як Hypercompute Cluster) спрощує розгортання та управління групами прискорювачів, розглядаючи їх як єдину уніфіковану систему.

Незабаром: Cluster Director з функціями Slurm та повного спостереження. Додайте до цього підтримку об’єднання в мережу до 30 000 графічних процесорів без блокування та безпечний RDMA з нульовою довірою, і ви отримаєте систему, створену для масштабування.

Чому це важливо: Запуск великих робочих навантажень зі штучним інтелектом — це не лише про чисту потужність. Ці інструменти допомагають підприємствам розгортати штучний інтелект там, де він потрібен, — на локальній, гібридній чи іншій платформі, — досягаючи при цьому безпеки, ефективності та простоти керування цими системами при масштабуванні.

Джерело: cloud.google.com

Розробка застосунків

Агенти Gemini Code Assist тепер доступні для вирішення повсякденних завдань розробника, таких як міграція коду, написання нових функцій, оглядів, тестування та документації. Вони вбудовані безпосередньо в Android Studio і навіть у нову дошку в стилі Kanban для полегшення відстеження проєктів.

У Firebase Studio новий агент App Prototyping може взяти ідею застосунку та перетворити її на робочий прототип у найкоротші терміни.

Із боку інфраструктури, Gemini Cloud Assist прискорює процес проєктування та розгортання. Він також допомагає вирішувати проблеми та тісно інтегрований з хмарними сервісами Google, включно з новітнім FinOps Hub 2.0.

Чому це важливо: Ці помічники зі штучним інтелектом скорочують час на розробку, знімають навантаження з операцій і надають командам більше пропускної здатності для роботи на вищому рівні. Інтегруючи штучний інтелект безпосередньо в інструменти, які розробники вже використовують, Google Cloud допомагає зробити розробку застосунків швидшою, безперебійнішою та економічно вигіднішою.

Новий Application Design Center пропонує візуальний, практичний спосіб створення та оновлення шаблонів застосунків. Cloud Hub слугує центральною інформаційною панеллю для всього, від розгортання та стану системи до налаштування продуктивності та використання ресурсів.

App Hub об’єднує понад 20 продуктів Google Cloud, щоб дати командам чітке уявлення про їхнє середовище, орієнтоване насамперед на застосунки. А завдяки абсолютно новому Cost Explorer (наразі в приватній попередній версії) ви можете заглибитися в метрики витрат і використання на рівні застосунків.

Чому це важливо: Для великих організацій, що працюють зі складними системами, ці інструменти привносять необхідну ясність. Завдяки кращому розумінню того, як створюються, працюють і скільки коштують застосунки, команди можуть ухвалювати більш розумні управлінські рішення.

Firebase стає все більш популярною платформою для розробників, які створюють застосунки зі штучним інтелектом, із новим набором інструментів, спрямованих на прискорення розробки та покращення якості. Нова Firebase Studio — це хмарне робоче середовище на базі платформи Gemini, яке допомагає розробникам швидко створювати та відправляти на прод повноцінні застосунки зі штучним інтелектом.

Агенти Gemini Code Assist вже вбудовані в Firebase; крім того, Firebase тепер підтримує Live API для моделей Gemini через Vertex AI, що дозволяє вести діалоги в реальному часі прямо в ваших застосунках.

Чому це важливо: Firebase Studio об’єднує все необхідне для швидкого створення сучасних застосунків на основі штучного інтелекту. Із Gemini, інтегрованим на кожному кроці, та підтримкою динамічної взаємодії в реальному часі, створювати цікаві для користувачів програми тепер простіше, ніж будь-коли.

Що стосується якості, то новий агент тестування додатків у Firebase App Distribution (наразі у попередній версії) допомагає підготувати мобільні застосунки до запуску, автоматично генеруючи та виконуючи повні наскрізні тести.

Тим часом, хостинг застосунків Firebase App Hosting вже став загальнодоступним. Він пропонує робочий процес на основі Git, пристосований для створення та розгортання повностекових веб-застосунків.

Чому це важливо: Ці доповнення допомагають розробникам раніше виявляти проблеми, покращувати стабільність і швидше випускати оновлення. Хостинг тісно інтегрований і налаштований належним чином — ідеально підходить для команд, які хочуть зосередитися на створенні, не переймаючись інфраструктурою.

Cloud Run та SaaS Runtime

Графічні процесори Cloud Run тепер повністю доступні, що дозволяє запускати інтенсивні робочі навантаження на GPU в безсерверному середовищі. Крім того, публічний попередній перегляд регіональних розгортань Cloud Run підвищує відмовостійкість, а приватний попередній перегляд робочих пулів для користувачів Kafka додає підтримку робочих навантажень на основі pull.

Тим часом SaaS Runtime пропонує повне рішення для управління життєвим циклом, щоб допомогти провайдерам SaaS моделювати, розгортати та експлуатувати свої сервіси з мінімальними зусиллями або взагалі без них, із вбудованими інструментами для швидкого додавання можливостей штучного інтелекту.

Чому це важливо: Ці оновлення розширюють можливості Cloud Run, роблячи його надійним вибором для вимогливих, критично важливих застосунків, таких як AI- та ML-інференції, а також підвищують надійність та підтримку архітектури, керованої подіями. У свою чергу, SaaS Runtime зменшує головний біль при розробці та експлуатації.

Обчислення

Нові віртуальні машини C4D на базі процесорів AMD EPYC та спеціальної архітектури Titanium від Google забезпечують на 30% вищу продуктивність, ніж попередні покоління.

ВМ C4, побудовані на чипах Intel Granite Rapids, мають найвищу тактову частоту серед усіх віртуальних машин Compute Engine — до 4,2 ГГц — і ще вищу продуктивність локального SSD-накопичувача.

Віртуальні машини H4D, призначені для високопродуктивних обчислень, забезпечують найвищу швидкість роботи вузла та кожного ядра, а також одну з найкращих в індустрії смуг пропускання для оперативної пам’яті.

Чому це важливо: Ці віртуальні машини надають клієнтам більше гнучкості. Незалежно від того, чи запускаєте ви інтенсивне моделювання, оптимізуєте процеси з великим обсягом вводу/виводу, чи просто потребуєте надійних загальних обчислень, ці нові сімейства забезпечують необхідну продуктивність без перевитрат.

Google Cloud також представляє нові ВМ, адаптовані для конкретних ентерпрайз-потреб. Серія M4, сертифікована для критично важливих розгортань SAP HANA, пропонує на 65% краще співвідношення ціни та продуктивності.

Сімейство Z3, орієнтоване на робочі навантаження з великими обсягами пам’яті, тепер включає в себе більші форми та Titanium SSD, а також фізичні варіанти, які масштабуються до 72 ТБ.

Крім того, адаптер Titanium ML інтегрує мережеві карти NVIDIA ConnectX-7, щоб забезпечити пропускну здатність між графічними процесорами в 3,2 Тбіт/с. Офлоуд-процесори Titanium підключають ці кластери GPU до Jupiter, високошвидкісного центру обробки даних Google.

Чому це важливо: Ці спеціалізовані віртуальні машини створені для завдань, які не можуть дозволити собі уповільнення. Від корпоративних баз даних до масштабного навчання моделей штучного інтелекту — вони оптимізовані для швидкості, надійності та продуктивності. Оновлене сімейство Titanium, зокрема, допомагає підтримувати об’ємні переміщення даних і масштабованість, яких вимагає сучасний штучний інтелект.

Контейнери та Kubernetes

- GKE Inference Gateway додає інтелектуальне масштабування та балансування навантаження, адаптоване для генеративних моделей штучного інтелекту.

- GKE Inference Quickstart автоматизує процес налаштування інфраструктури штучного інтелекту.

- RayTurbo на GKE, побудований за допомогою Anyscale, прискорює обробку даних в 4,5 рази і скорочує вимоги до вузлів вдвічі.

Чому це важливо: Ці інструменти полегшують розгортання та керування робочими навантаженнями інференцій, дозволяючи вам обслуговувати моделі штучного інтелекту в масштабі, заощаджуючи час і гроші. Значне підвищення ефективності RayTurbo особливо цінне для пайплайнів, що потребують великих обсягів даних.

- Cluster Director для GKE (тепер GA) дозволяє працювати з великими парками віртуальних машин на графічних процесорах як з єдиним, простим в управлінні блоком.

- GKE Autopilot щойно отримав швидке планування та масштабування подів. Його оптимізована для контейнерів обчислювальна платформа також скоро з’явиться у стандартних кластерах GKE.

Чому це важливо: Ці оновлення підвищують продуктивність, покращують роботу та скорочують витрати, що має вирішальне значення для великих завдань зі штучним інтелектом та інших вимогливих робочих навантажень. Швидший та розумніший автопілот робить керований Kubernetes ще більш привабливим варіантом для команд будь-якого розміру

Клієнти

Google Cloud висвітлив сотні нових клієнтських історій з усього світу, які показують, як організації різного типу використовують інструменти штучного інтелекту

- КомпаніяBending Spoons обробляє 60 мільйонів фотографій на день за допомогою Imagen 3.

- DBS скоротила час обробки дзвінків на 20% за допомогою Customer Engagement Suite.

- DETR штату Невада використовує BigQuery і Vertex AI для роботи Асистента апеляцій, який допомагає затверджувати пільги в чотири рази швидше.

- Mercado Libre запустив Vertex AI Search у трьох пілотних країнах, що допомогло 100 мільйонам користувачів швидше знаходити товари та принесло мільйони доларів додаткового доходу.

- Spotify використовує BigQuery, щоб персоналізувати досвід для більш ніж 675 мільйонів користувачів у всьому світі.

- Verizon покращує обслуговування клієнтів для понад 115 мільйонів підключень за допомогою інструментів штучного інтелекту Google Cloud, зокрема персонального дослідного асистента.

- Wayfair оновлює атрибути товарів у п’ять разів швидше завдяки Vertex AI.

Чому це важливо: Ці історії не просто вражають — вони є доказом того, наскільки широко використовується штучний інтелект Google Cloud. Компанії отримують реальні результати — від прискорення операцій і підвищення креативності до поліпшення обслуговування клієнтів і збільшення доходів. Очевидно, що штучний інтелект — це вже не просто модне слово, а інструмент, який змінює роботу індустрій.

Бази даних

AlloyDB AI тепер підтримує запити до структурованих даних природною мовою, дозволяючи розробникам використовувати звичайну англійську поряд з SQL. Він також має покращений векторний пошук з перехресним переранжуванням, мультимодальні вбудовування та нову модель Gemini Embedding для кращого розуміння тексту.

Крім того, набір інструментів MCP Toolbox для баз даних полегшує підключення агентів ШІ безпосередньо до корпоративних систем даних.

Чому це важливо: Ці оновлення допомагають подолати бар’єр між користувачами та їхніми даними. Підтримка природної мови відкриває доступ до баз даних для більшої кількості людей, а покращений векторний пошук підвищує продуктивність для таких завдань ШІ, як семантичний пошук. Можливість пов’язувати ШІ-агентів з базами даних є ключовим фактором для створення більш розумних корпоративних інструментів.

Firestore тепер пропонує сумісність з MongoDB з мультирегіональною реплікацією, сильну узгодженість і 99,999% SLA, що дає розробникам звичний інтерфейс з надійністю корпоративного рівня.

Google Cloud також розширив свої пропозиції Oracle за рахунок нового сервісу баз даних Oracle Base Database Service та загальнодоступного Oracle Exadata X11M, що забезпечує більшу гнучкість та контроль робочих навантажень Oracle.

Тим часом, служба міграції баз даних (DMS) тепер підтримує міграцію з SQL Server на PostgreSQL, а новий Центр управління базами даних (Database Center), що став загальнодоступним, пропонує централізовану площину керування на основі штучного інтелекту для всіх баз даних.

Чому це важливо: Ці оновлення є великою перемогою для корпоративних клієнтів. Незалежно від того, чи здійснюється міграція зі старих систем, чи оптимізація критично важливих робочих навантажень, команди тепер мають більше можливостей, кращу продуктивність та чіткіші шляхи для розвитку. Сумісність із MongoDB робить Firestore привабливим вибором для величезної кількості розробників, а розширена підтримка Oracle задовольняє основні потреби великих організацій.

Джерело: cloud.google.com

Аналітика даних

BigQuery продовжує розвиватися у справді автономну платформу, яка поєднує аналітику та штучний інтелект від початку до кінця. В основі цієї еволюції лежить BigQuery Knowledge Engine, який використовує Gemini для розуміння зв’язків у схемах, моделювання даних і навіть пропонує терміни з глосарію.

Тим часом новий механізм запитів BigQuery AI може обробляти як структуровані, так і неструктуровані дані, спираючись на реальні знання та розмірковування Gemini.

Безліч нових функцій, таких як вбудовані пайплайни, підготовка даних, виявлення аномалій, семантичний пошук і аналіз внесків, зараз або загальнодоступні, або перебувають у стадії попереднього перегляду.

Чому це важливо: Ці оновлення впроваджують штучний інтелект безпосередньо в процес обробки, дозволяючи користувачам переходити від сирих даних до інсайтів швидше, ніж будь-коли. Незалежно від того, чи ви виявляєте аномалії, готуєте дані або ставите складні запитання, BigQuery тепер допомагає вам робити це більш інтуїтивно і з меншою кількістю ручної роботи.

BigQuery також тепер підтримує мультимодальні таблиці, ставлячись до неструктурованих даних як до first-class citizen.

Universal Catalog (раніше Dataplex Catalog) пропонує уніфікований рівень метаданих, сумісність метасховищ між механізмами та бізнес-глосарій для кращого управління.

Нові безперервні запити дозволяють проводити майже миттєвий аналіз потокових даних, а кероване аварійне відновлення — тепер загальнодоступне — забезпечує автоматичний фейловер і реплікацію майже в реальному часі, щоб зберегти дані захищеними та доступними.

Чому це важливо: Ці оновлення підвищують готовність BigQuery до роботи в складних корпоративних середовищах. Аналітика в реальному часі, підтримка відкритої екосистеми, суворе управління чи стійкість до катастроф, BigQuery тепер ще краще оснащений для роботи з великомасштабними, критично важливими робочими навантаженнями.

Looker також отримує значне оновлення з функціями, що роблять бізнес-аналітику ближчою до звичайних користувачів. Розмовна аналітика (наразі у попередньому доступі) дозволяє бізнес-користувачам досліджувати дані, просто ставлячи запитання природною мовою.

Gemini в Looker тепер підтримує такі функції, як Помічник візуалізації, Помічник формул та Розмовна аналітика, що доступні для всіх користувачів. Існує навіть інтерпретатор коду, який виконує такі завдання, як прогнозування та виявлення аномалій — без необхідності експертизи в Python.

Чому це важливо: Це знижує планку для аналізу даних, роблячи потужні інсайти доступними для людей з усієї організації, а не тільки для команд, що працюють з даними. Це великий крок до ширшої грамотності в роботі з даними та швидшого, більш впевненого ухвалення рішень.

Google Workspace: Продуктивність на основі штучного інтелекту

- У Google Таблицях з’явилася функція Допоможи мені проаналізувати, яка розумно витягує інформацію з ваших даних, не вимагаючи від вас навіть запиту.

- У Документах функція Аудіоогляд перетворює документи на чіткі, природні записи або резюме в стилі подкастів.

- Тим часом Google Workspace Flows автоматизує такі повсякденні завдання, як управління погодженнями, пошук інформації про клієнтів та узагальнення електронних листів.

Чому це важливо: Ці інструменти на основі штучного інтелекту вбудовані прямо в застосунки, якими ви користуєтеся щодня, допомагаючи вам працювати розумніше, знаходити нові ідеї та мінімізувати повторювану роботу. Результат? Значне підвищення продуктивності та новий спосіб взаємодії команд із даними та документами.

Робота в мережі

Google Cloud масштабує свою інфраструктуру, щоб задовольнити надзвичайні вимоги найбільших сучасних моделей штучного інтелекту та сервісів, побудованих на їхній основі.

Нова мережева підтримка до 30 000 графічних процесорів на кластер у повністю неблокуючому сетапі в поєднанні з безпекою Zero-Trust RDMA та надшвидкою мережею GPU-GPU RDMA зі швидкістю 3,2 Тбіт/с усуває основний бар’єр для продуктивності.

Впровадження технологій Cloud Interconnect на 400 Гбіт/с та Cross-Cloud Interconnect ще більше підвищує пропускну здатність, пропонуючи спроможність, що вчетверо перевершує попередні покоління.

Чому це важливо: Ці оновлення мають вирішальне значення для навчання та запуску величезних моделей штучного інтелекту. Завдяки таким мережевим можливостям розробники та підприємства можуть створювати та розгортати системи штучного інтелекту, які раніше були просто неможливими, не турбуючись про те, що інфраструктура їх стримуватиме.

Google Cloud також зміцнює свою основу для глобального зв’язку та безпеки. Cloud WAN тепер забезпечує повністю керовану, високопродуктивну мережу, яка знижує загальну вартість володіння (TCO) на 40%, одночасно підвищуючи швидкість і надійність для розподілених корпоративних середовищ. Що стосується безпеки, то оновлення містять:

- DNS Armor, який виявляє спроби ексфільтрації даних.

- Ієрархічні політики в Cloud Armor для більш точного контролю безпеки.

- Хмарний NGFW з фільтрацією доменів 7-го рівня.

- Інтегровану мережеву DLP, що забезпечує захист конфіденційних даних під час передачі в режимі реального часу.

Чому це важливо: Незалежно від того, чи керуєте ви гібридним середовищем, чи масштабуєте його в декількох хмарах, ці можливості допомагають підприємствам залишатися швидкими, підключеними та захищеними. Підвищення продуктивності та посилення системи безпеки необхідні для захисту сучасних застосунків від дедалі складніших загроз.

Джерело: cloud.google.com

Безпека

Google Unified Security об’єднує все в одному місці — видимість, виявлення загроз, операції з безпеки на основі штучного інтелекту, безперервну віртуальну червону команду, корпоративний браузер і ноу-хау Mandiant.

Два нових агенти штучного інтелекту посилюють гру: Alert Triage Agent занурюється в оповіщення, розслідує на льоту, збирає весь контекст і повідомляє про те, що відбувається.

Malware Analysis Agent досліджує підозрілий код і навіть може запускати скрипти, щоб розпакувати хитрі, обфусковані загрози.

Чому це важливо: Це комплексне рішення, що працює на основі розумної автоматизації, полегшує роботу команд безпеки, прискорює виявлення загроз і підвищує точність їхньої обробки, скорочуючи при цьому ручну роботу.

Програма захисту від ризиків (уявіть собі кіберстрахування зі знижкою) тепер включає нових партнерів, таких як Beazley і Chubb, що дає бізнесу більше можливостей.

Mandiant Retainer пропонує доступ до найкращих експертів на вимогу, коли потрібні розслідування або інформація про загрози. А партнерство Mandiant Consulting з Rubrik та Cohesity допомагає компаніям швидше відновлюватися після атак з меншим часом простою та меншими витратами на відновлення.

Чому це важливо: Разом вони роблять кібер-ризики менш загрозливими, надаючи компаніям надійний фінансовий захист та експертну підтримку, коли вони цього найбільше потребують.

Сховище

Обсяг пулів зберігання даних Hyperdisk збільшився в п’ять разів — до 5 ПБ, а абсолютно нові пули Hyperdisk Exapools забезпечують найбільше і найшвидше блокове сховище, доступне в будь-якій загальнодоступній хмарі, — ексабайти ємності і терабайти в секунду за швидкістю.

Крім того, є Rapid Storage — нове зональне хмарне сховище з блискавичною затримкою довільного читання/запису до 1 мс, доступом до даних, який прискорився в 20 разів, і пропускною спроможністю до 6 ТБ/с.

Anywhere Cache скорочує затримку до 70%, тримаючи дані ближче до графічних і паралельних процесорів і прискорюючи обробку штучного інтелекту.

Також, Google Cloud Managed Lustre пропонує повністю керовану, високопродуктивну паралельну файлову систему, яка може обробляти петабайтні навантаження з наднизькою затримкою і мільйонами операцій вводу-виводу за секунду.

Чому це важливо: Ці оновлення усувають вузькі місця в системі зберігання даних, які можуть сповільнювати навчання та висновки штучного інтелекту, забезпечуючи значний приріст швидкості, обсягу та оперативності зберігання даних. Результат? Швидша розробка моделей та оперативніший реліз рішень на базі штучного інтелекту.

Google Cloud також запустив Storage Intelligence — перший сервіс, який використовує великі мовні моделі для масштабного аналізу метаданих об’єктів і надає інформацію, що враховує специфіку середовища.

Чому це важливо: Це дозволяє командам розумніше керувати своїми сховищами, пропонуючи чітку видимість і контроль над величезними масивами даних, допомагаючи ухвалювати кращі рішення щодо розміщення, скорочення витрат і дотримання нормативних вимог.

Стартапи

Google Cloud посилює підтримку стартапів на ранніх стадіях розвитку, особливо тих, що працюють у сфері штучного інтелекту. Завдяки великому партнерству з Lightspeed портфельні компанії, що працюють у сфері штучного інтелекту, тепер можуть отримати до $150 000 у хмарних крéдитах — на додаток до того, що вже доступно в рамках програми Google Cloud для стартапів.

Крім того, стартапи отримують додаткові $10 000 крéдитів спеціально для партнерських моделей через Vertex AI Model Garden, заохочуючи практичні експерименти з моделями штучного інтелекту від Anthropic, Meta та інших компаній. Нова програма Startup Perks також відкриває двері до найкращих рішень від таких партнерів, як Datadog, Elastic та GitLab.

Чому це важливо: Ці ініціативи роблять створення та розвиток стартапів у Google Cloud набагато доступнішим. Пропонуючи щедрі крéдити, партнерські інструменти та різноманітні моделі штучного інтелекту, Google Cloud допомагає стимулювати інновації та зміцнює своє місце в якості платформи для технологічних компаній, що розвиваються.

Про нас

Як надійний Google Cloud Premier Partner, бізнес Cloudfresh розширив можливості понад 200 000 професіоналів у більш ніж 70 країнах. Наші консалтингові послуги у сфері Google Cloud з’єднують вас із командою сертифікованих експертів, які глибоко розуміються на інструментах, технологіях та передових практиках Google Cloud, що дозволяє вам зосередитися на своєму основному бізнесі, максимізуючи при цьому цінність ваших інвестицій у хмарні технології.