Czym jest GCP i jak możesz go wykorzystać w swojej firmie?

Google Cloud Next 2025: Wszystkie oczy na sztuczną inteligencję

- Sztuczna inteligencja i systemy wieloagentowe

- Infrastruktura sztucznej inteligencji

- Rozwój aplikacji

- Cloud Run i SaaS Runtime

- Obliczenia

- Kontenery i Kubernetes

- Klienci

- Bazy danych

- Analityka danych

- Google Workspace: Produktywność oparta na sztucznej inteligencji

- Praca w sieci

- Bezpieczeństwo

- Pamięć masowa

- Startupy

- O nas

Podczas Google Cloud Next 2025 odbyło się ponad 10 keynote’ów i sesji spotlight, a także 700 szczegółowych prezentacji. Wydarzenie było pełne, obejmowało każdy aspekt innowacji i oferowało wyraźny obraz najnowszych dodatków Google Cloud i strategicznego ukierunkowania.

Teraz, gdy mieliśmy szansę wchłonąć wszystko i trochę czasu na refleksję, przyjrzyjmy się bliżej każdemu kluczowemu obszarowi i wyróżnijmy najbardziej wpływowe ogłoszenia z Google Cloud Next ’25.

Sztuczna inteligencja i systemy wieloagentowe

Dzięki publicznemu podglądowi Gemini 2.5 Pro – obecnie na szczycie rankingu Chatbot Arena – oraz nadchodzącemu Gemini 2.5 Flash, który został zbudowany z myślą o szybkości i wydajności, więcej osób ma teraz dostęp do potężnych narzędzi do rozumowania i kodowania.

Co więcej, Google Cloud uczynił Vertex AI jedyną platformą hiperskalarną oferującą generatywne modele multimedialne w zakresie wideo, obrazów, dźwięku i muzyki. Dzieje się tak dzięki Imagen 3, Chirp 3, Lyria i Veo 2, a także Meta’s Llama 4 (obecnie ogólnie dostępnej) i nowemu partnerstwu z Ai2.

Dlaczego to ma znaczenie: To pozycjonuje Vertex AI jako platformę najwyższej klasy do tworzenia multimodalnych aplikacji AI. Deweloperzy i firmy otrzymują niezrównaną mieszankę opcji i narzędzi do pracy z szeroką gamą typów danych – coś, co wyraźnie wyróżnia Google Cloud w przestrzeni sztucznej inteligencji.

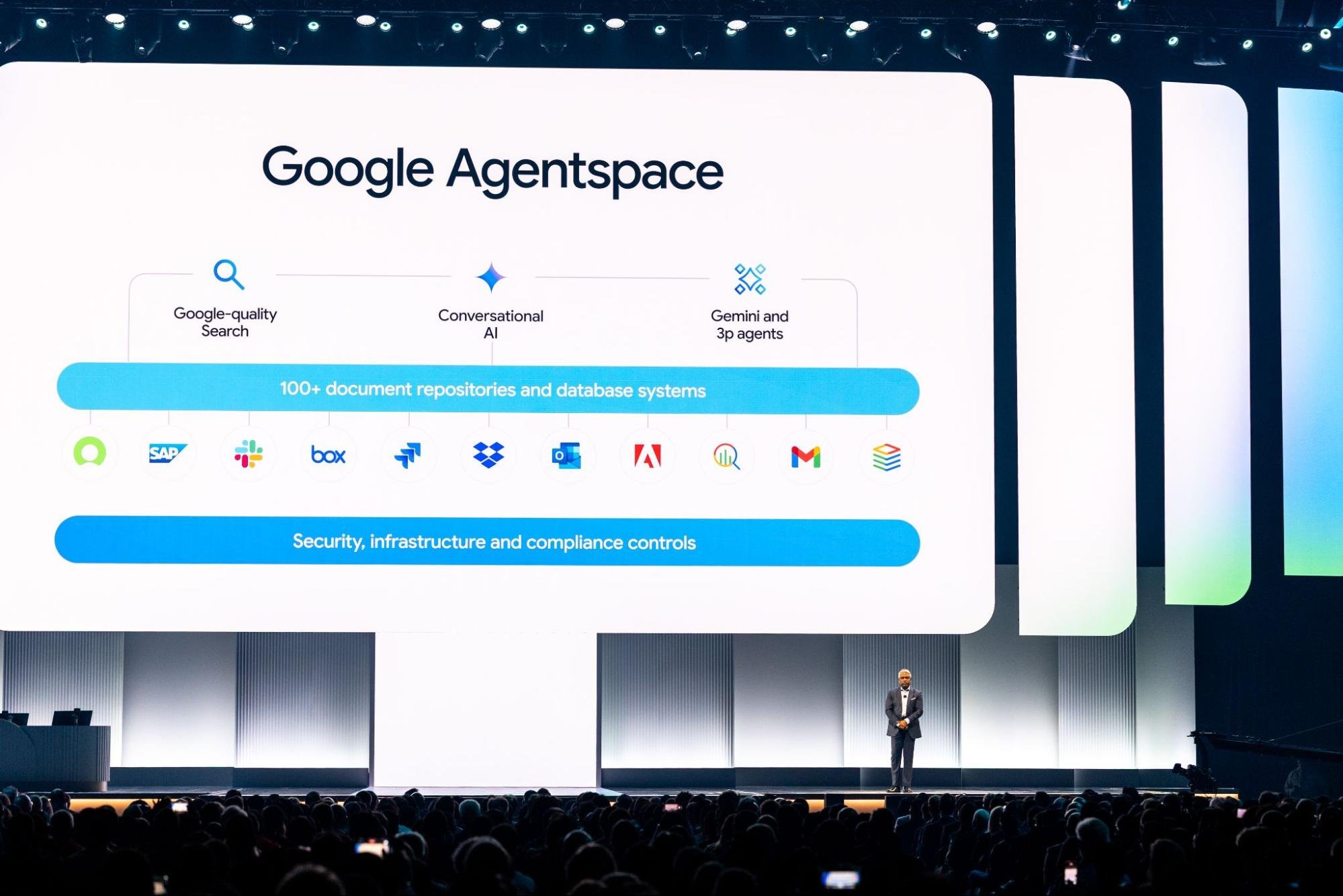

Google Cloud wprowadził również Agent Development Kit (ADK) i otwarty protokół Agent2Agent (A2A), który jest już obsługiwany przez dziesiątki partnerów. Narzędzia te stanowią podstawę do budowania i zarządzania złożonymi systemami współdziałających agentów AI.

Nowy silnik Agent Engine dodaje w pełni zarządzane środowisko do testowania i wdrażania tych systemów na dużą skalę. Narzędzia takie jak Agentspace – teraz połączone z Chrome Enterprise – wraz z Agent Gallery i no-code Designer, zostały stworzone, aby pomóc firmom we wdrażaniu agentów AI w zespołach i działach, oddając moc sztucznej inteligencji w ręce zwykłych użytkowników.

Dlaczego to ma znaczenie: Oznacza to wyraźną zmianę w kierunku pomocy firmom nie tylko w badaniu sztucznej inteligencji, ale także w jej wykorzystaniu. Otwarte standardy przyciągają społeczność, a usługi zarządzane i przyjazne dla użytkownika narzędzia obniżają barierę wejścia. Oznacza to, że więcej organizacji może wykorzystywać sztuczną inteligencję do pracy o dużym wpływie, takiej jak badania, strategia i innowacje – bez konieczności posiadania zespołu inżynierów, aby to osiągnąć.

Źródło: cloud.google.com

Infrastruktura sztucznej inteligencji

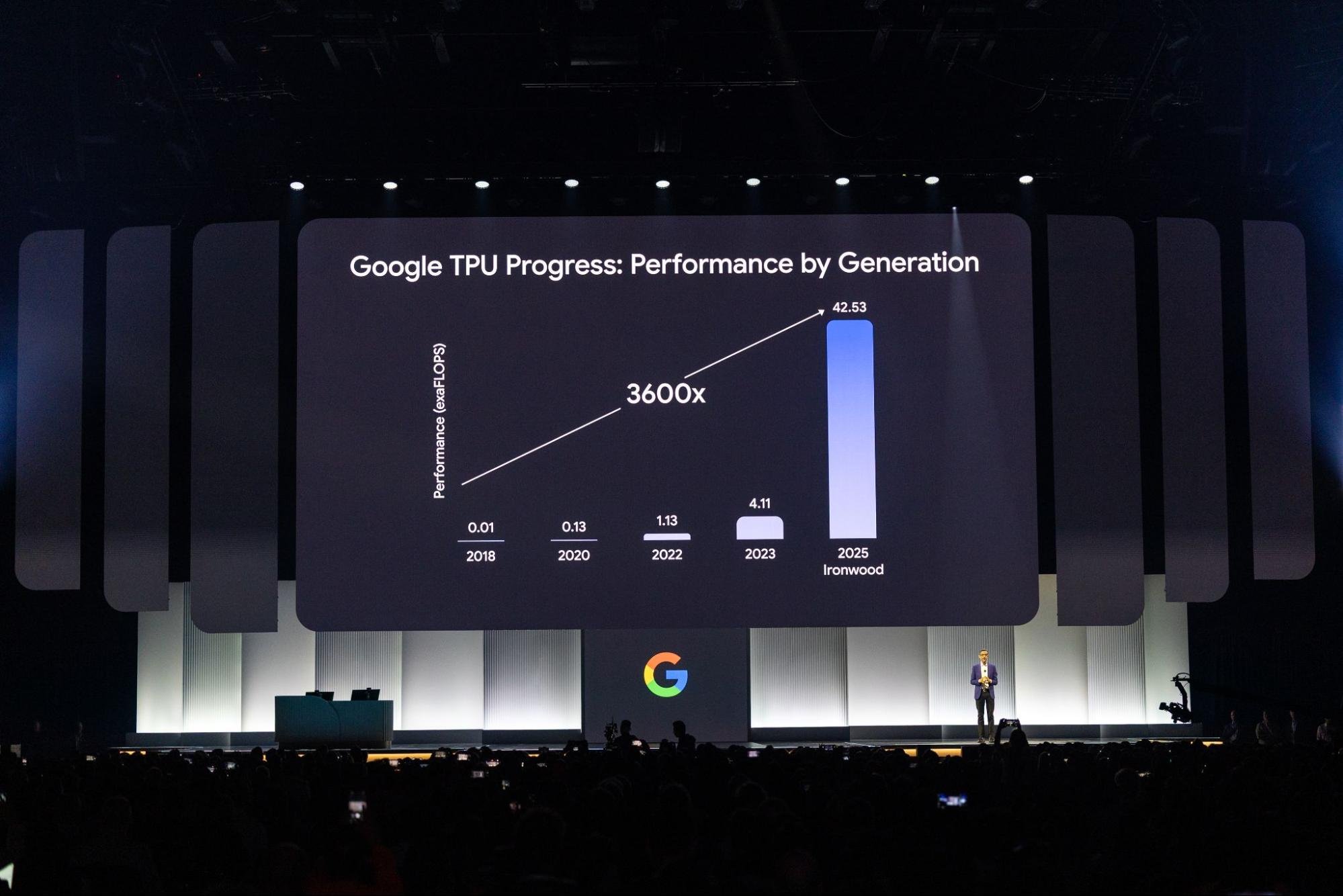

Nadchodzący Ironwood (TPU siódmej generacji Google) i uruchomienie maszyn wirtualnych A4 i A4X – zasilanych przez procesory graficzne Blackwell firmy NVIDIA (B200 i GB200) – pokazują dążenie Google Cloud do pozostania w czołówce innowacji sprzętowych AI.

Google Cloud był pierwszym dużym dostawcą oferującym te procesory graficzne Blackwell i jest już w kolejce, aby być jednym z pierwszych, którzy zaoferują również chipy Vera Rubin firmy NVIDIA. Po raz pierwszy klienci mają również dostęp do Pathways on Cloud, rozproszonego środowiska wykonawczego DeepMind stworzonego do obsługi dużych, złożonych modeli sztucznej inteligencji.

Dlaczego to ma znaczenie: Aktualizacje te zapewniają użytkownikom ogromną moc obliczeniową i wydajność do szkolenia i uruchamiania modeli na dużą skalę. Jest to niezbędne, ponieważ rośnie zapotrzebowanie na poważną moc obliczeniową AI. A dzięki wczesnemu wprowadzeniu na rynek najwyższej klasy procesorów graficznych NVIDIA, Google Cloud zapewnia kluczową przewagę klientom, którzy potrzebują wysokowydajnych systemów teraz – a nie później.

Google Distributed Cloud (GDC) współpracuje z firmą NVIDIA, aby wprowadzić modele Gemini do systemów zasilanych przez Blackwell, w tym w środowiskach lokalnych. Cluster Director (wcześniej znany jako Hypercompute Cluster) upraszcza sposób, w jaki organizacje wdrażają i zarządzają grupami akceleratorów, traktując je jako pojedynczy, ujednolicony system.

Już wkrótce: Cluster Director dla Slurm i funkcje obserwowalności w pełnym zakresie. Dodajmy do tego obsługę sieci do 30 000 układów GPU w konfiguracji nieblokującej i bezpieczne RDMA z Zero Trust, a otrzymamy system zbudowany z myślą o skalowaniu.

Dlaczego to ma znaczenie: Uruchamianie dużych obciążeń AI to nie tylko surowa moc. Narzędzia te pomagają przedsiębiorstwom wdrażać sztuczną inteligencję wszędzie tam, gdzie jej potrzebują – lokalnie, hybrydowo lub w inny sposób – jednocześnie upewniając się, że systemy te są bezpieczne, wydajne i łatwiejsze w zarządzaniu na dużą skalę.

Źródło: cloud.google.com

Rozwój aplikacji

Agenci Gemini Code Assist są teraz dostępni do obsługi codziennych zadań programistycznych, takich jak migracja kodu, pisanie nowych funkcji, recenzje, testowanie i dokumentacja. Są one wbudowane bezpośrednio w Android Studio, a nawet w nową tablicę w stylu Kanban, ułatwiającą śledzenie projektów.

W Firebase Studio nowy agent App Prototyping może błyskawicznie przekształcić pomysły na aplikacje w działające prototypy.

Po stronie infrastruktury Gemini Cloud Assist przyspiesza proces projektowania i wdrażania. Pomaga również w rozwiązywaniu problemów i jest ściśle zintegrowany z usługami Google Cloud, w tym z najnowszym FinOps Hub 2.0.

Dlaczego to ma znaczenie: Ci asystenci sztucznej inteligencji skracają czas programowania, odciążają operacje i zapewniają zespołom większą przepustowość do pracy na wyższym poziomie. Integrując sztuczną inteligencję bezpośrednio z narzędziami, z których już korzystają programiści, Google Cloud pomaga przyspieszyć, usprawnić i obniżyć koszty tworzenia aplikacji.

Nowe Centrum Projektowania Aplikacji oferuje wizualny, praktyczny sposób tworzenia i aktualizowania szablonów aplikacji. Cloud Hub działa jako centralny pulpit nawigacyjny do wszystkiego, od wdrożeń i kondycji systemu po dostrajanie wydajności i wykorzystanie zasobów.

App Hub łączy ponad 20 produktów Google Cloud, aby zapewnić zespołom przejrzysty, zorientowany na aplikacje widok ich środowisk. A dzięki zupełnie nowemu eksploratorowi kosztów (obecnie w prywatnej wersji zapoznawczej) można teraz zagłębić się w wydatki i wskaźniki użytkowania na poziomie aplikacji.

Dlaczego to ma znaczenie: W przypadku dużych organizacji pracujących w złożonych systemach narzędzia te zapewniają bardzo potrzebną przejrzystość. Dzięki lepszemu wglądowi w to, jak aplikacje są tworzone, uruchamiane i kosztowane, zespoły mogą podejmować mądrzejsze decyzje dotyczące zarządzania.

Firebase staje się platformą dla programistów tworzących aplikacje oparte na sztucznej inteligencji, z nowym zestawem narzędzi mających na celu przyspieszenie rozwoju i poprawę jakości. Nowe Firebase Studio to oparty na chmurze obszar roboczy oparty na sztucznej inteligencji, zbudowany wokół platformy Gemini.

Został zaprojektowany, aby pomóc programistom w szybkim uruchomieniu i dostarczeniu pełnowymiarowych, gotowych do produkcji aplikacji AI. Agenci Gemini Code Assist są bezpośrednio wbudowani – ponadto Firebase obsługuje teraz Live API dla modeli Gemini za pośrednictwem Vertex AI, umożliwiając konwersację w czasie rzeczywistym bezpośrednio w aplikacjach.

Dlaczego to ma znaczenie: Firebase Studio łączy w sobie wszystko, co potrzebne do szybkiego tworzenia nowoczesnych aplikacji opartych na sztucznej inteligencji. Dzięki Gemini zintegrowanemu na każdym kroku i obsłudze dynamicznych interakcji na żywo, tworzenie angażujących doświadczeń użytkowników jest łatwiejsze niż kiedykolwiek.

Jeśli chodzi o jakość, nowy agent testowania aplikacji w Firebase App Distribution (obecnie w wersji zapoznawczej) pomaga przygotować aplikacje mobilne do uruchomienia poprzez automatyczne generowanie i uruchamianie pełnych testów end-to-end.

Tymczasem Firebase App Hosting jest teraz ogólnie dostępny. Oferuje on oparty na Git przepływ pracy dostosowany do budowania i wdrażania aplikacji internetowych typu full-stack.

Dlaczego to ma znaczenie: Dodatki te pomagają deweloperom wcześniej wychwytywać błędy, poprawiać stabilność aplikacji i szybciej dostarczać aktualizacje. Hosting jest ściśle zintegrowany i opiniotwórczy we właściwy sposób – idealny dla zespołów, które chcą skupić się na tworzeniu bez konieczności zajmowania się infrastrukturą.

Cloud Run i SaaS Runtime

Układy GPU Cloud Run są teraz w pełni dostępne, umożliwiając uruchamianie obciążeń intensywnie wykorzystujących GPU w konfiguracji bezserwerowej. Ponadto publiczna wersja zapoznawcza wieloregionalnych wdrożeń dla Cloud Run zwiększa odporność aplikacji, a prywatna wersja zapoznawcza pul pracowników dla konsumentów Kafka dodaje obsługę obciążeń opartych na ciągnięciu.

W międzyczasie SaaS Runtime oferuje kompletne rozwiązanie do zarządzania cyklem życia, które pomaga dostawcom SaaS modelować, wdrażać i obsługiwać swoje usługi przy niewielkim lub żadnym wysiłku, z wbudowanymi narzędziami do szybkiego dodawania funkcji sztucznej inteligencji.

Dlaczego to ma znaczenie: Aktualizacje te rozszerzają możliwości Cloud Run, czyniąc z niego solidny wybór dla wymagających, krytycznych aplikacji, takich jak AI i wnioskowanie ML, jednocześnie poprawiając niezawodność i obsługę architektury sterowanej zdarzeniami. Z kolei SaaS Runtime redukuje rozwój i operacyjne bóle głowy.

Obliczenia

Nowe maszyny wirtualne C4D, oparte na procesorach AMD EPYC i niestandardowej architekturze Google Titanium, zapewniają nawet o 30% wyższą wydajność niż poprzednie generacje.

Maszyny wirtualne C4, zbudowane na chipach Intel Granite Rapids, idą jeszcze dalej, oferując najwyższe prędkości taktowania spośród wszystkich maszyn wirtualnych Compute Engine – do 4,2 GHz – oraz wyższą wydajność lokalnych dysków SSD.

W przypadku intensywnego użytkowania HPC, maszyny wirtualne H4D oferują najwyższą prędkość całego węzła i na rdzeń, a także wiodącą w branży przepustowość pamięci.

Dlaczego to ma znaczenie: Te maszyny wirtualne zapewniają klientom większą elastyczność. Niezależnie od tego, czy prowadzisz intensywne symulacje, optymalizujesz procesy wymagające dużej ilości operacji we/wy, czy po prostu potrzebujesz niezawodnego ogólnego przetwarzania, te nowe rodziny oferują wydajność, której potrzebujesz – bez nadmiernych wydatków.

Google Cloud wprowadza również nowe maszyny wirtualne dostosowane do konkretnych potrzeb przedsiębiorstw. Seria M4, certyfikowana do wdrożeń SAP HANA o znaczeniu krytycznym, oferuje do 65% lepszy stosunek ceny do wydajności.

Rodzina Z3, skoncentrowana na obciążeniach pamięci masowej, obejmuje teraz większe kształty i dyski SSD Titanium, a także opcje bare-metal, które skalują się do 72 TB.

Co więcej, adapter Titanium ML integruje karty NVIDIA ConnectX-7 NIC, aby zapewnić przepustowość 3,2 Tb/s GPU-to-GPU. Procesory odciążające Titanium łączą te klastry GPU z Jupiter, szybką siecią centrów danych Google.

Dlaczego to ma znaczenie: Te wyspecjalizowane maszyny wirtualne są przeznaczone do zadań, które nie mogą sobie pozwolić na spowolnienia. Są one zoptymalizowane pod kątem szybkości, niezawodności i wydajności, od korporacyjnych baz danych po szkolenie modeli sztucznej inteligencji na dużą skalę. W szczególności ulepszona rodzina Titanium pomaga wspierać masowy ruch danych i skalowalność, których wymaga nowoczesna sztuczna inteligencja.

Kontenery i Kubernetes

- GKE Inference Gateway dodaje inteligentne skalowanie i równoważenie obciążenia dostosowane do generatywnych modeli sztucznej inteligencji.

- GKE Inference Quickstart automatyzuje konfigurację infrastruktury sztucznej inteligencji.

- RayTurbo na GKE, zbudowany z Anyscale, przyspiesza przetwarzanie danych 4,5x i zmniejsza wymagania dotyczące węzłów o połowę.

Dlaczego to ma znaczenie: Narzędzia te ułatwiają wdrażanie i zarządzanie obciążeniami związanymi z wnioskowaniem, umożliwiając obsługę modeli AI na dużą skalę przy jednoczesnej oszczędności czasu i pieniędzy. Duży wzrost wydajności RayTurbo jest szczególnie cenny w przypadku potoków wymagających dużej ilości danych.

- Cluster Director dla GKE (obecnie GA) pozwala traktować duże floty maszyn wirtualnych z procesorami GPU jako pojedynczą, łatwą w zarządzaniu jednostkę.

- GKE Autopilot właśnie przyspieszył planowanie i skalowanie podów. Platforma obliczeniowa zoptymalizowana pod kątem kontenerów wkrótce trafi także do standardowych klastrów GKE.

Dlaczego ma to znaczenie: Aktualizacje te zwiększają wydajność, usprawniają operacje i obniżają koszty – co ma kluczowe znaczenie dla dużych zadań AI i innych wymagających obciążeń. Szybszy i inteligentniejszy Autopilot sprawia, że zarządzany Kubernetes jest jeszcze bardziej atrakcyjną opcją dla zespołów każdej wielkości.

Klienci

Google Cloud przedstawiło setki nowych historii klientów z całego świata, pokazując, jak organizacje różnego rodzaju wykorzystują narzędzia AI do pracy:

- Bending Spoons przetwarza oszałamiającą liczbę 60 milionów zdjęć dziennie za pomocą Imagen 3.

- FirmaDBS skróciła czas obsługi połączeń o 20% dzięki pakietowi Customer Engagement Suite.

- Nevada DETR wykorzystuje BigQuery i Vertex AI do zasilania asystenta odwołań, który pomaga sędziom zatwierdzać świadczenia cztery razy szybciej.

- Mercado Libre uruchomiło Vertex AI Search w trzech krajach pilotażowych, pomagając 100 milionom użytkowników szybciej znajdować produkty i generując miliony dodatkowych przychodów.

- Spotify wykorzystuje BigQuery do personalizacji doświadczeń dla ponad 675 milionów użytkowników na całym świecie.

- Verizon poprawia obsługę klienta dla ponad 115 milionów połączeń za pomocą narzędzi AI Google Cloud, w tym Personal Research Assistant.

- Wayfair aktualizuje atrybuty produktów pięć razy szybciej dzięki Vertex AI.

Dlaczego to ma znaczenie: Te historie są nie tylko imponujące – są dowodem na to, jak szeroko wdrażana jest sztuczna inteligencja Google Cloud. Od przyspieszenia operacji i zwiększenia kreatywności po poprawę obsługi klienta i zwiększenie przychodów – firmy widzą realne rezultaty. Oczywiste jest, że sztuczna inteligencja nie jest już tylko modnym hasłem – to narzędzie, które zmienia sposób działania branż.

Bazy danych

AlloyDB AI obsługuje teraz zapytania w języku naturalnym danych strukturalnych, umożliwiając programistom używanie zwykłego języka angielskiego obok SQL. Posiada również ulepszone wyszukiwanie wektorowe z rerankingiem uwagi krzyżowej, multimodalne osadzanie i nowy model osadzania Gemini dla bogatszego rozumienia tekstu.

Co więcej, MCP Toolbox for Databases ułatwia łączenie agentów AI bezpośrednio z systemami danych przedsiębiorstwa.

Dlaczego to ma znaczenie: Aktualizacje te pomagają przełamać barierę między użytkownikami a ich danymi. Obsługa języka naturalnego otwiera dostęp do baz danych dla większej liczby osób, a lepsze wyszukiwanie wektorowe zwiększa wydajność zadań AI, takich jak dopasowywanie semantyczne. Możliwość łączenia agentów AI z bazami danych jest kluczowym czynnikiem umożliwiającym tworzenie inteligentniejszych narzędzi dla przedsiębiorstw.

Firestore oferuje teraz kompatybilność z MongoDB z replikacją w wielu regionach, silną spójnością i umową SLAna poziomie 99,999% – zapewniając programistom znajomy interfejs z niezawodnością klasy korporacyjnej.

Google Cloud rozszerzyło również swoją ofertę Oracle o nową usługę Oracle Base Database Service i ogólną dostępność Oracle Exadata X11M, zapewniając większą elastyczność i kontrolę dla obciążeń Oracle.

Tymczasem usługa Database Migration Service (DMS) obsługuje teraz migracje z SQL Server do PostgreSQL, a nowe Database Center, obecnie ogólnie dostępne, oferuje scentralizowaną, opartą na sztucznej inteligencji płaszczyznę kontroli do zarządzania flotami baz danych na całym świecie.

Dlaczego to ma znaczenie: Aktualizacje te stanowią dużą wygraną dla klientów korporacyjnych. Niezależnie od tego, czy chodzi o migrację ze starszych systemów, czy optymalizację obciążeń o znaczeniu krytycznym, zespoły mają teraz więcej opcji, lepszą wydajność i jaśniejsze ścieżki rozwoju. Kompatybilność z MongoDB sprawia, że Firestore jest atrakcyjnym wyborem dla ogromnej bazy programistów, a rozszerzone wsparcie Oracle zaspokaja główną potrzebę dużych organizacji.

Źródło: cloud.google.com

Analityka danych

BigQuery nadal ewoluuje w kierunku prawdziwie autonomicznej platformy, która łączy analitykę i sztuczną inteligencję od początku do końca. Sercem tej ewolucji jest BigQuery Knowledge Engine, który wykorzystuje Gemini do zrozumienia relacji schematów, modelowania danych, a nawet sugerowania terminów słownikowych.

Tymczasem nowy silnik zapytań BigQuery AI może obsługiwać zarówno ustrukturyzowane, jak i nieustrukturyzowane dane, czerpiąc z rzeczywistej wiedzy i rozumowania Gemini.

Wiele nowych funkcji – takich jak wbudowane potoki, przygotowanie danych, wykrywanie anomalii, wyszukiwanie semantyczne i analiza wkładu – jest teraz ogólnie dostępnych lub w wersji zapoznawczej.

Dlaczego to ma znaczenie: Aktualizacje te wprowadzają sztuczną inteligencję bezpośrednio do przepływu danych, umożliwiając użytkownikom przejście od surowych danych do spostrzeżeń szybciej niż kiedykolwiek. Niezależnie od tego, czy wykrywasz anomalie, przygotowujesz dane, czy zadajesz złożone pytania, BigQuery pomaga teraz robić to bardziej intuicyjnie – i przy mniejszym nakładzie pracy ręcznej.

BigQuery obsługuje teraz również tabele multimodalne, traktując dane nieustrukturyzowane jako obywatela pierwszej kategorii.

Universal Catalog (dawniej Dataplex Catalog) oferuje ujednoliconą warstwę metadanych, z interoperacyjnością metastore między silnikami i glosariuszem biznesowym dla lepszego zarządzania.

Nowe ciągłe zapytania umożliwiają niemal natychmiastową analizę danych strumieniowych, a zarządzane odzyskiwanie po awarii – teraz ogólnie dostępne – zapewnia automatyczne przełączanie awaryjne i replikację w czasie zbliżonym do rzeczywistego, aby dane były chronione i dostępne.

Dlaczego to ma znaczenie: Aktualizacje te wzmacniają gotowość BigQuery do pracy w złożonych środowiskach korporacyjnych. Niezależnie od tego, czy chodzi o analitykę w czasie rzeczywistym, obsługę otwartego ekosystemu, ścisłe zarządzanie, czy odporność na awarie, BigQuery jest teraz jeszcze lepiej przygotowany do obsługi dużych obciążeń o znaczeniu krytycznym.

Looker również otrzymuje dużą aktualizację, z nowymi funkcjami, które przybliżają analitykę biznesową codziennym użytkownikom.

Analityka konwersacyjna (obecnie w wersji zapoznawczej) pozwala użytkownikom biznesowym eksplorować dane po prostu zadając pytania w języku naturalnym.

Gemini w Looker obsługuje teraz funkcje takie jak Visualization Assistant, Formula Assistant i Conversational Analytics, dostępne dla wszystkich użytkowników Looker. Dostępny jest nawet Interpreter Kodu, który obsługuje zadania takie jak prognozowanie i wykrywanie anomalii – bez potrzeby znajomości języka Python.

Dlaczego to ma znaczenie: Obniża to poprzeczkę dla analizy danych, udostępniając potężne spostrzeżenia ludziom w całej organizacji – nie tylko zespołom zajmującym się danymi. To duży krok w kierunku szerszej znajomości danych i szybszego, pewniejszego podejmowania decyzji.

Google Workspace: Produktywność oparta na sztucznej inteligencji

- Arkusze Google zawierają teraz funkcję Pomóż mi analizować, która inteligentnie wyciąga wnioski z danych bez konieczności zadawania pytań.

- W Dokumentach, Przegląd audio zamienia dokumenty w wyraźne, naturalnie brzmiące podsumowania audio lub w stylu podcastu.

- Tymczasem Google Workspace Flows automatyzuje codzienne zadania, takie jak zarządzanie zatwierdzeniami, wyszukiwanie informacji o klientach i podsumowywanie wiadomości e-mail.

Dlaczego to ma znaczenie: Te narzędzia oparte na sztucznej inteligencji są wbudowane bezpośrednio w aplikacje, z których korzystasz na co dzień, pomagając Ci pracować mądrzej, wydobywać spostrzeżenia i ograniczać powtarzalną pracę. Rezultat? Duży wzrost produktywności i nowy sposób interakcji zespołów z danymi i dokumentami.

Praca w sieci

Google Cloud skaluje swoją infrastrukturę, aby sprostać niezwykłym wymaganiom dzisiejszych największych modeli sztucznej inteligencji – i usług na nich opartych.

Nowa obsługa sieci do 30 000 procesorów graficznych na klaster w całkowicie nieblokującej konfiguracji, w połączeniu z zabezpieczeniami Zero-Trust RDMA i ultraszybką siecią 3,2 Tbps GPU-to-GPU RDMA, usuwa główną barierę wydajności.

Wprowadzenie 400G Cloud Interconnect i Cross-Cloud Interconnect dodatkowo zwiększa przepustowość, oferując 4-krotnie większą przepustowość niż poprzednie generacje.

Dlaczego to ma znaczenie: Ulepszenia te mają kluczowe znaczenie dla szkolenia i uruchamiania ogromnych modeli sztucznej inteligencji. Dzięki takiemu potencjałowi sieciowemu programiści i przedsiębiorstwa mogą tworzyć i wdrażać systemy sztucznej inteligencji, które wcześniej były po prostu niewykonalne – bez obawy, że infrastruktura je powstrzyma.

Google Cloud wzmacnia również swoją sieć szkieletową w zakresie globalnej łączności i bezpieczeństwa. Cloud WAN zapewnia teraz w pełni zarządzaną, wysokowydajną sieć, która zmniejsza całkowity koszt posiadania nawet o 40%, jednocześnie poprawiając szybkość i niezawodność rozproszonych środowisk korporacyjnych. Po stronie bezpieczeństwa aktualizacje obejmują:

- DNS Armor, który wykrywa próby eksfiltracji danych.

- Hierarchiczne zasady w Cloud Armor dla bardziej precyzyjnej kontroli bezpieczeństwa.

- Cloud NGFW z filtrowaniem domen warstwy 7.

- Inline Network DLP, oferujący ochronę w czasie rzeczywistym dla wrażliwych danych w tranzycie.

Dlaczego to ma znaczenie: Niezależnie od tego, czy zarządzasz konfiguracją hybrydową, czy skalujesz w wielu chmurach, funkcje te pomagają przedsiębiorstwom zachować szybkość, łączność i bezpieczeństwo. Wzrost wydajności i silniejsza ochrona są niezbędne do ochrony nowoczesnych aplikacji przed coraz bardziej złożonymi zagrożeniami.

Źródło: cloud.google.com

Bezpieczeństwo

Google Unified Security łączy wszystko w jednym miejscu – widoczność, wykrywanie zagrożeń, operacje bezpieczeństwa oparte na sztucznej inteligencji, ciągły wirtualny red teaming, przeglądarkę korporacyjną i know-how Mandiant.

Dwóch nowych agentów AI przyspiesza grę: Alert Triage Agent zagłębia się w alerty, bada w locie, zbiera cały kontekst i dzwoni, co się dzieje.

Agent analizy złośliwego oprogramowania bada podejrzany kod, a nawet może uruchamiać skrypty, aby rozpakować trudne, zaciemnione zagrożenia.

Dlaczego to ma znaczenie: Ta kompleksowa konfiguracja, oparta na inteligentnej automatyzacji, ułatwia pracę zespołom bezpieczeństwa, przyspiesza wykrywanie zagrożeń i poprawia dokładność ich obsługi – przy jednoczesnym ograniczeniu pracy ręcznej. Program ochrony przed ryzykiem (pomyśl o zniżkowym ubezpieczeniu cybernetycznym) obejmuje teraz nowych partnerów, takich jak Beazley i Chubb, dając firmom więcej opcji.

Mandiant Retainer oferuje dostęp na żądanie do najlepszych ekspertów, gdy potrzebne są dochodzenia lub informacje o zagrożeniach. Z kolei partnerstwo Mandiant Consulting z Rubrik i Cohesity pomaga firmom szybciej odbijać się od dna dzięki krótszym przestojom i niższym kosztom odzyskiwania danych po ataku.

Dlaczego to ma znaczenie: Wszystko to razem sprawia, że ryzyko cybernetyczne jest mniej zniechęcające – dając firmom solidną ochronę finansową i wsparcie ekspertów, gdy tego najbardziej potrzebują.

Pamięć masowa

Pule Hyperdisk Storage wzrosły pięciokrotnie do 5 PiB, podczas gdy zupełnie nowe Hyperdisk Exapools zapewniają największą i najszybszą blokową pamięć masową dostępną w dowolnej chmurze publicznej – myśląc o eksabajtach pojemności i terabajtach na sekundę prędkości.

Jest też Rapid Storage, nowy strefowy Cloud Storage bucket z błyskawicznym losowym opóźnieniem odczytu/zapisu poniżej 1 ms, dostępem do danych, który jest 20 razy szybszy, a przepustowość osiąga 6 TB/s. Anywhere Cache zmniejsza opóźnienia nawet o 70%, utrzymując dane blisko procesorów graficznych i układów TPU, przyspieszając przetwarzanie sztucznej inteligencji.

Ponadto Google Cloud Managed Lustre oferuje w pełni zarządzany, wysokowydajny równoległy system plików, który może obsługiwać obciążenia w skali petabajtów z bardzo niskimi opóźnieniami i milionami IOPS (operacji wejścia/wyjścia na sekundę).

Dlaczego to ma znaczenie: Aktualizacje te przełamują wąskie gardła danych, które mogą spowalniać szkolenie i wnioskowanie AI, zapewniając ogromny wzrost szybkości, rozmiaru i szybkości reakcji pamięci masowej. Rezultat? Szybsze opracowywanie modeli i szybsze wdrażanie rozwiązań opartych na sztucznej inteligencji.

Google Cloud uruchomiło również Storage Intelligence, pierwszą usługę wykorzystującą duże modele językowe do analizowania metadanych obiektów na dużą skalę i dostarczania informacji specyficznych dla środowiska.

Dlaczego to ma znaczenie: Umożliwia to zespołom inteligentniejsze zarządzanie pamięcią masową, oferując przejrzystą widoczność i kontrolę nad ogromnymi zasobami danych, pomagając w podejmowaniu lepszych decyzji dotyczących umieszczania danych, obniżania kosztów i zachowania zgodności z przepisami.

Startupy

Google Cloud zwiększa swoje wsparcie dla startupów na wczesnym etapie rozwoju, zwłaszcza tych skupionych na sztucznej inteligencji. Dzięki znaczącemu partnerstwu z Lightspeed, spółki portfelowe AI mogą teraz uzyskać do 150 000 USD kredytów w chmurze – oprócz tego, co jest już dostępne w ramach programu Google Cloud for Startups.

Co więcej, startupy otrzymują dodatkowe 10 000 USD kredytów specjalnie dla modeli partnerskich za pośrednictwem Vertex AI Model Garden, zachęcając do praktycznych eksperymentów z modelami AI z Anthropic, Meta i innych. Nowy program Startup Perks otwiera również drzwi do preferowanych rozwiązań od partnerów takich jak Datadog, Elastic i GitLab.

Dlaczego to ma znaczenie: Inicjatywy te sprawiają, że startupy mogą budować i rozwijać się w Google Cloud. Oferując hojne kredyty, narzędzia partnerskie i różnorodne modele sztucznej inteligencji, Google Cloud pomaga napędzać innowacje i umacnia swoją pozycję jako platformy dla rozwijających się firm technologicznych.

O nas

Jako zaufany partner Google Cloud Premier, Cloudfresh wzmocnił pozycję ponad 200 000 profesjonalistów w ponad 70 krajach. Nasze usługi konsultingowe Google Cloud łączą Cię z zespołem certyfikowanych ekspertów dogłębnie zaznajomionych z narzędziami, technologiami i najlepszymi praktykami Google Cloud – pozwalając Ci skupić się na swojej podstawowej działalności, jednocześnie maksymalizując wartość inwestycji w chmurę.