Analiza danych AI na Google Cloud Platform i jej koszt

- Analityka danych AI w praktyce

- Vertex AI

- Gemini: Generatywna AI do analizy danych

- O nas

W dzisiejszym artykule chcielibyśmy zagłębić się w strukturę kosztów analityki danych AI na Google Cloud Platform (GCP), u jednego z największych dostawców infrastruktury chmurowej pod względem udziału w rynku.

Warto zauważyć, że we wszystkich oficjalnych zasobach Google Cloud sztuczna inteligencja (AI) i uczenie maszynowe (ML) są nierozłączne i traktowane jako jedna kategoria.

Liczba powiązanych produktów waha się od 17 do 27, co pokazuje, że Google aktywnie rozszerza ofertę, aby sprostać rosnącemu zapotrzebowaniu na nowe funkcjonalności.

W tym artykule skupimy się na aspektach cenowych dwóch podstawowych produktów GCP, a mianowicie Vertex AI i Gemini, a także na narzędziach do analityki AI, takich jak BigQuery i Looker.

Jako globalny Partner Google Cloud na poziomie Premier, dołożymy wszelkich starań, aby odpowiedzieć na następujące pytania:

- Czy przechowywanie danych treningowych dla Neural Architecture Search w BigQuery jest tak samo kosztowne, jak samo uruchomienie Vertex AI NAS?

- Ile kosztuje korzystanie z BigQuery jako repozytorium cech (features) offline dla uczenia maszynowego (Vertex AI Feature Store)?

- Jaką cenę ma spokój ducha? Monitorowanie modeli Vertex AI z danymi treningowymi i predykcyjnymi przechowywanymi w BigQuery.

- Czy subskrypcja Gemini Code Assist jest warta swojej ceny? Spojrzenie na analitykę konwersacyjną w Lookerze i optymalizację kosztów w BigQuery.

Zaczynajmy!

Analityka danych AI w praktyce

Każdy z poniższych przypadków użycia pokazuje, w jaki sposób organizacje z bardzo różnych branż wykorzystują narzędzia Google Cloud AI do rozwiązywania dużych wyzwań, zwiększania wydajności i tworzenia nowych możliwości.

Transport i mobilność

- Geotab wykorzystuje BigQuery i Vertex AI do przetwarzania miliardów punktów danych każdego dnia z ponad 4,6 miliona pojazdów. Wyniki te umożliwiają inteligentniejsze zarządzanie flotą, bezpieczniejszą jazdę, dekarbonizację transportu oraz dostarczają wniosków, które pomagają miastom stawać się bezpieczniejszymi i bardziej zrównoważonymi.

Finanse i ubezpieczenia

- Dojo obsługuje miliony bezpiecznych, błyskawicznych płatności dziennie. Dzięki modelom Looker i Gemini firma testuje nowe sposoby naturalnej interakcji firm z informacjami o płatnościach.

- United Wholesale Mortgage przekształca proces udzielania kredytów hipotecznych za pomocą Vertex AI, Gemini i BigQuery. W ciągu zaledwie dziewięciu miesięcy podwojono wydajność underwriterów, skracając czas finalizacji pożyczek dla 50 000 brokerów i ich klientów.

- Hiscox zbudował pierwszy oparty na AI model underwritingu leadów dla ubezpieczycieli, wykorzystując BigQuery i Vertex AI. Złożone wyceny ryzyka, które kiedyś zajmowały trzy dni, teraz trwają zaledwie kilka minut.

- MSCI, wiodący wydawca indeksów i wskaźników rynkowych, wykorzystuje Vertex AI, BigQuery i Cloud Run do wzbogacania informacji o prawie milionie lokalizacji aktywów. Te analizy, wspierane przez analitykę danych AI, pomagają klientom mierzyć ryzyko związane z klimatem i zarządzać nim.

- Apex Fintech Solutions opiera się na BigQuery, Lookerze i Google Kubernetes Engine, aby rozszerzyć dostęp do analiz finansowych, uprościć inwestowanie i przygotować się na innowacje oparte na AI.

- 180 Seguros ulepszyło swoją wewnętrzną platformę danych dzięki Google Cloud AI i BigQuery. Pracownicy śledzą teraz wskaźniki operacyjne, a zapytania działają trzy razy szybciej.

- Aluga Mais, brazylijski startup z branży wynajmu, wykorzystuje Vertex AI, Document AI i BigQuery do budowania profili finansowych klientów. Przyspieszyło to analizę rejestracji z 90 minut do zaledwie 24 sekund.

Handel detaliczny i dobra konsumpcyjne

- Tchibo, europejska marka kawy i e-commerce, opiera się na Vertex AI i BigQuery w prognozowaniu popytu. Jej rozwiązanie do analizy danych oparte na AI, DEMON, generuje ponad sześć milionów prognoz dziennie, pomagając firmie zarządzać zapasami, obniżać koszty logistyki i poprawiać dostępność produktów.

- Unilever zdigitalizował swoją dystrybucję handlową dzięki BigQuery. Firma przetwarza obecnie 75 000 zamówień dziennie i obsługuje miliony sprzedawców detalicznych na rynkach wschodzących.

- Gymshark, brytyjska marka i społeczność fitness, zbudowała zunifikowaną platformę danych z BigQuery, Lookerem, Dataflow i Vertex AI. System ten zapewnia głębszy wgląd w zachowania klientów i spersonalizowane doświadczenia fitness na dużą skalę.

Opieka zdrowotna

- ARC Innovation w Sheba Medical Center wykorzystuje Looker Studio i BigQuery ML do tworzenia rozwiązań analityki danych AI, które usprawniają podejmowanie kluczowych decyzji klinicznych w leczeniu raka jajnika.

Technologia i usługi

- Bosch SDS umieścił zrównoważony rozwój w centrum swoich działań dzięki Google Cloud. Korzystając z Kubernetesa, BigQuery i Firebase, firma zbudowała silnik poznawczy oparty na AI, który wysyła alerty w czasie rzeczywistym. Rezultaty obejmują obniżenie kosztów energii o 12%, poprawę komfortu w pomieszczeniach i większe wykorzystanie energii odnawialnej.

Media i rozrywka

- Spotify nawiązało współpracę z Google Cloud, aby obsługiwać ogromną skalę za pomocą BigQuery. Platforma przetwarza ogromne ilości informacji, aby zapewnić spersonalizowane doświadczenia słuchowe ponad 675 milionom użytkowników na całym świecie.

Poznaj więcej studiów przypadku GCP.

Vertex AI

Jeśli chodzi o budowanie i zarządzanie modelami uczenia maszynowego w Google Cloud, Vertex AI oferuje zestaw narzędzi obejmujący pełne spektrum – od odkrywania najlepszych architektur neuronowych, przez organizowanie cech (features), po monitorowanie wydajności modeli.

Niezależnie od tego, czy eksperymentujesz z Neural Architecture Search (NAS), centralizujesz dane cech za pomocą Feature Store, czy monitorujesz jakość modelu za pomocą Model Monitoring, narzędzia te pozwalają efektywnie projektować, trenować i utrzymywać systemy analityki danych AI.

Przyjrzyjmy się bliżej, jak działa każdy komponent, ile kosztuje Vertex AI i jak wpisuje się w rzeczywisty przepływ pracy ML.

Neural Architecture Search (NAS)

Vertex AI Neural Architecture Search (NAS) to narzędzie do wyszukiwania najdokładniejszych architektur neuronowych. Pozwala ono uwzględniać lub ignorować ograniczenia, takie jak opóźnienia, rozmiar pamięci i niestandardowe metryki.

Dzięki możliwości eksploracji przestrzeni poszukiwań o wielkości nawet 10^20, NAS pomógł stworzyć zaawansowane modele widzenia komputerowego, takie jak Nasnet, MNasnet, EfficientNet, NAS-FPN i SpineNet.

Jednak NAS nie jest rozwiązaniem typu plug-and-play. Wymaga dedykowanego zespołu do konfigurowania i testowania parametrów architektonicznych, takich jak rozmiar jądra czy liczba kanałów. Najlepiej nadaje się do przypadków, w których tradycyjne metody, takie jak dostrajanie hiperparametrów, nie przynoszą już poprawy.

Nie zaleca się korzystania z NAS, jeśli masz ograniczone lub silnie niezbalansowane dane, ponieważ opiera się on na eksperymentach na dużą skalę i dostępności danych.

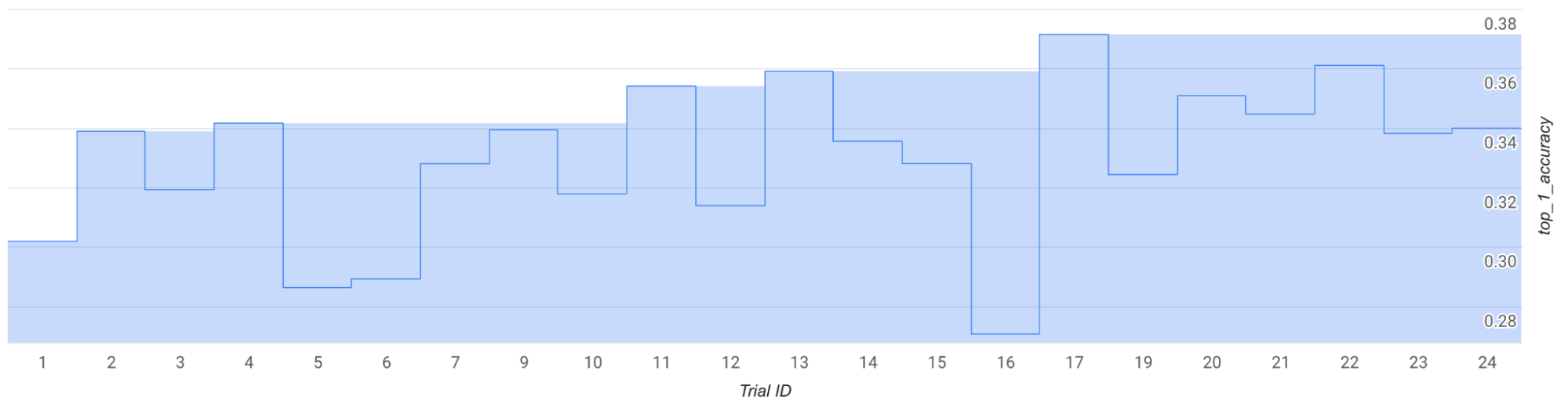

Uruchommy na przykład kilka zadań testowych, używając wstępnie skonfigurowanej przestrzeni poszukiwań i trenera MNasNet.

Na wykresie widać, że najlepsza nagroda na etapie 1 wzrasta z około 0,30 w próbie 1 do około 0,37 w próbie 17. Twoje wyniki mogą się nieznacznie różnić ze względu na losowość próbkowania, ale nadal powinieneś zauważyć tendencję wzrostową.

Należy pamiętać, że jest to tylko przebieg testowy, a nie dowód koncepcji (PoC) ani publiczny benchmark dla analityki danych opartej na AI.

- Całkowita liczba prób: 25

- Liczba GPU na próbę: 2

- Typ GPU: TESLA_T4

- Liczba CPU na próbę: 1

- Typ CPU: n1-highmem-16

- Średni czas treningu na próbę: 3 godziny

- Próby równoległe: 6

- Całkowite wykorzystanie limitu GPU: (liczba GPU na próbę × liczba prób równoległych) = 2 × 6 = 12

- Region: us-central1 (dane treningowe przechowywane w tym samym obszarze; dodatkowy limit nie jest wymagany)

- Czas wykonania: (całkowita liczba prób × czas treningu na próbę) ÷ (liczba prób równoległych) = (25 × 3) ÷ 6 = 12 godzin

- Wyrażone w GPU-godzinach: (całkowita liczba prób × czas treningu na próbę × liczba GPU na próbę) = 25 × 3 × 2 = 150 godzin T4

- Wyrażone w CPU-godzinach: (całkowita liczba prób × czas treningu na próbę × liczba CPU na próbę) = 25 × 3 × 1 = 75 godzin n1-highmem-16

Szacowany koszt wynosi około 185 USD. Oczywiście, można przerwać wcześniej, aby obniżyć wydatki.

Elastyczność NAS sprawia, że jest to potężne, ale i drogie rozwiązanie. Jest najlepsze dla przedsiębiorstw gotowych do inwestowania w innowacyjne projekty modelowania na dużą skalę.

Oprócz maszyn wirtualnych, akceleratorów i dysków (w zależności od typu i regionu) będziesz potrzebować również Cloud Storage.

Najważniejszy jest tutaj koszt przechowywania danych treningowych, gdzie BigQuery może być również używane z własnym modelem cenowym. Na przykład pierwsze 10 GiB miesięcznie jest bezpłatne do analizy danych AI i innych celów.

Integracja Vertex AI i BigQuery: Feature Store

Vertex AI Feature Store to scentralizowane repozytorium do zarządzania i przetwarzania cech (features) na potrzeby uczenia maszynowego.

Magazyny cech (feature stores) są podstawową częścią kompleksowej infrastruktury MLOps w GCP. Pozwalają one zespołom Data Science i ML przyspieszyć cykle wdrożeń poprzez organizowanie cech w całej firmie.

Dzięki magazynowi cech łatwiej jest tworzyć, przechowywać, udostępniać, wyszukiwać i dostarczać cechy do aplikacji ML.

Ponadto BigQuery może służyć jako magazyn cech w trybie offline.

Oznacza to, że organizacje mogą korzystać z istniejącej infrastruktury, unikać powielania danych na potrzeby analityki AI i obniżać koszty.

Zespoły mogą również wykorzystywać BigQuery SQL do inżynierii cech (feature engineering) z wbudowanymi ustawieniami dostępu i kontroli.

Ponieważ BigQuery jest używany do operacji w trybie offline, będziesz rozliczany za takie czynności jak ładowanie danych, uruchamianie zapytań i przechowywanie zestawów danych offline.

Na przykład, jeśli korzystasz z BigQuery Storage Write API w regionie europe-west4 (Holandia), otrzymujesz 2 TiB miesięcznie za darmo. Powyżej tego limitu koszt wynosi 0,03 USD za każdy dodatkowy GiB.

Monitorowanie modeli

Vertex AI Model Monitoring pozwala uruchamiać zadania na żądanie lub zaplanowane w celu śledzenia jakości modeli tabelarycznych.

Jeśli skonfigurowane są alerty, system powiadomi Cię za każdym razem, gdy wskaźniki przekroczą predefiniowane progi.

Załóżmy, że zbudowałeś predykcyjny model analityczny AI do śledzenia wartości życiowej klienta (Customer Lifetime Value, CLV). Po uruchomieniu nowego programu lojalnościowego pierwotne cechy mogą już nie odzwierciedlać zachowań klientów. Ten rodzaj zmiany jest znany jako dryf danych (data drift).

Monitorowanie modelu może wykrywać dryf i ostrzegać, gdy przekroczy on określone progi. W tym momencie może być konieczna ponowna ocena lub ponowne wytrenowanie modelu analityki danych opartego na AI.

Cena wynosi 3,5 USD za GB analizy, wliczając w to zarówno dane treningowe, jak i predykcyjne przechowywane w tabelach BigQuery.

Dodatkowe opłaty obowiązują za inne produkty Google Cloud używane wraz z Monitorowaniem Modeli, takie jak przechowywanie danych w BigQuery.

Przykład:

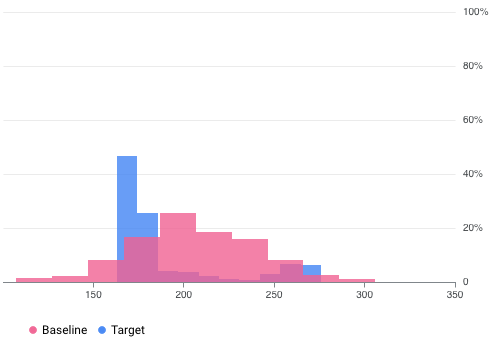

Zespół Data Science uruchamia monitorowanie modelu wytrenowanego na danych z BigQuery. Po przekonwertowaniu danych treningowych do formatu TfRecord, ich rozmiar wynosi 5,0 GB. Dane predykcyjne zarejestrowane między 10:00 a 11:00 rano wynoszą łącznie 0,5 GB, a między 16:00 a 17:00 kolejne 0,3 GB. Całkowity koszt skonfigurowania monitorowania modelu wynosi:

(5,0 × 3,5 USD) + ((0,5 + 0,3) × 3,5 USD) = 20,3 USD

Inne komponenty Vertex AI współpracujące z BigQuery obejmują Workbench, Deep Learning Containers, Deep Learning VMs i AI Platform Pipelines. Opłaty obowiązują w przypadku uruchamiania zapytań SQL w określonym notatniku (zasób kodu w BigQuery Studio).

Gemini: Generatywna AI do analizy danych

Jeśli chodzi o wykorzystanie pełnego potencjału AI w analityce danych, Gemini dodaje inteligentną warstwę nad BigQuery i Lookerem.

Od upraszczania złożonych zapytań i wizualnej eksploracji zbiorów danych, po generowanie raportów i dashboardów za pomocą poleceń w języku naturalnym, Gemini pomaga zespołom pracować szybciej, podejmować mądrzejsze decyzje i uzyskiwać większą wartość z każdego przepływu pracy.

Zobaczmy, jak ulepsza każdą platformę i wspiera rzeczywiste operacje.

BigQuery

Gemini w BigQuery wprowadza analitykę danych opartą na AI do Twojego magazynu danych. Zapewnia inteligentne narzędzia do zarządzania i optymalizacji obciążeń w całym cyklu ich życia.

Gemini wspiera analityków, inżynierów, data scientistów i administratorów baz danych dzięki funkcjom takim jak generowanie i autouzupełnianie kodu w językach Python i SQL.

Dzięki tłumaczeniu języka naturalnego na SQL możesz szybko tworzyć zapytania, przyspieszyć development i łatwiej testować.

Gemini może również wyjaśniać złożone zapytania SQL w prostym języku, dzięki czemu są one bardziej dostępne.

Wyszukiwanie jest wzbogacone o funkcje semantyczne. Możesz natychmiast znaleźć odpowiednie tabele, pobrać trafne zapytania i uruchomić je jednym kliknięciem.

W przypadku migracji lub transformacji do Google Cloud, Gemini pomaga tłumaczyć zapytania i redukować ręczną konfigurację analityki danych AI.

Interfejs Data Canvas dodaje wizualny sposób eksploracji. Możesz uruchomić analizę opartą na poleceniach (na przykład: „Znajdź tabele sprzedaży w Charkowie”), a następnie przesłać wyniki do produkcji, wyeksportować je do dalszej analizy w BigQuery SQL lub udostępnić za pośrednictwem Lookera, Looker Studio, Arkuszy Google lub Prezentacji Google.

Gemini pomaga również w optymalizacji kosztów chmury i wydajności na każdym etapie potoku danych (data pipeline). Usprawnienia te przenoszą się na kolejne etapy pracy (downstream workflows), niezależnie od tego, czy tworzysz dashboardy, modele ML, czy aplikacje do analizy danych AI.

I nie ograniczają się one do SQL czy Pythona. Bezserwerowe potoki analizy danych w Sparku również na tym zyskują, ułatwiając szybkie wychwytywanie i naprawianie błędów.

Looker: Analiza konwersacyjna

Gemini w Lookerze ułatwia generowanie raportów z wykresami, tytułami, motywami i układami, a wszystko to za pomocą prostego polecenia.

Otrzymujesz raport bazowy, który możesz dalej dostosowywać za pomocą języka naturalnego. Pomyśl o tym jak o wbudowanym konsultancie Lookera!

Zaawansowany asystent może również generować kod JSON dla niestandardowych wizualizacji, dzięki czemu tworzenie i dostosowywanie wykresów jest szybsze.

Kolejna przydatna funkcja to automatyczne generowanie slajdów. Raporty z analizy danych oparte na AI można eksportować do Prezentacji Google z objaśnieniami tekstowymi, które podkreślają kluczowe wnioski.

Możesz nawet tworzyć pola obliczeniowe bez konieczności zapamiętywania skomplikowanych formuł, co znacznie ułatwia analizę ad hoc.

Ceny

Pełny zestaw funkcji Gemini w BigQuery jest dostępny w ramach subskrypcji Gemini Code Assist Standard. Cena wynosi 22,80 USD za użytkownika miesięcznie lub 19,00 USD za użytkownika miesięcznie przy 12-miesięcznym zobowiązaniu.

Są one również dostępne w ramach edycji BigQuery Enterprise, Enterprise Plus i On-Demand Compute. Dokładna cena będzie się różnić w zależności od slot-godzin (slot-hours) i lokalizacji.

Wszystkie powyższe opcje podlegają również określonym limitom (quotas).

Jeśli chodzi o Gemini w Lookerze, jest on obecnie bezpłatny, choć może to ulec zmianie w dowolnym momencie.

O nas

Jako Premier Partner, Cloudfresh zapewnia najwyższej jakości usługi konsultingowe Google Cloud i pomaga organizacjom w pełni wykorzystać AI do analizy danych.

Niezależnie od tego, czy chodzi o budowanie inteligentniejszych przepływów pracy za pomocą Gemini, trenowanie i wdrażanie modeli w Vertex AI, przekształcanie danych z BigQuery w działania, czy ożywianie wniosków za pomocą Lookera, otrzymujesz rozwiązanie dopasowane do rzeczywistych potrzeb biznesowych.

Od strategii po wdrożenie, zespół Cloudfresh projektuje skalowalne, bezpieczne i opłacalne systemy, dzięki czemu możesz działać szybciej, podejmować bardziej świadome decyzje i generować trwałą wartość dzięki przypadkom użycia Google Cloud GenAI, które dostosowują się do Twojego sposobu pracy.

Aby rozpocząć rozmowę, wypełnij krótki formularz poniżej.