Qu’est-ce que GCP et comment l’exploiter dans votre entreprise ?

Google Cloud Next 2025 : Tous les regards tournés vers l’IA

- Intelligence artificielle et systèmes multi-agents

- L’infrastructure de l’intelligence artificielle

- Développement d’applications

- Cloud Run & SaaS Runtime

- Calcul

- Conteneurs et Kubernetes

- Les clients

- Bases de données

- Analyse des données

- Google Workspace : Une productivité alimentée par l’IA

- Réseau

- Sécurité

- Stockage

- Startups

- À propos de nous

L’événement Google Cloud Next 2025 a posposé plus de 10 keynotes et sessions thématiques, ainsi qu’à 700 présentations approfondies. Riche en contenu, il a couvert tous les aspects de l’innovation et offert un aperçu clair des nouveautés et des axes stratégiques de Google Cloud.

Maintenant que nous avons eu le temps d’assimilier les annonces et prendre du recul, examinons de plus près chaque domaine clé et mettons en lumière les annonces les plus marquantes de Google Cloud Next ’25.

Intelligence artificielle et systèmes multi-agents

Plus de personnes ont désormais accès à des outils puissants de raisonnement et de programmation grâce à l’aperçu public de Gemini 2.5 Pro — actuellement en tête du classement Chatbot Arena — et à l’arrivée prochaine de Gemini 2.5 Flash, conçu pour la rapidité et l’efficacité.

De plus, Google Cloud a fait de Vertex AI la seule plateforme hyperscaleur à proposer des modèles génératifs multimédias couvrant la vidéo, les images, l’audio et la musique. Cela est rendu possible grâce à Imagen 3, Chirp 3, Lyria, et Veo 2, plus Llama 4 de Meta (maintenant disponible pour tous) et à un nouveau partenariat avec Ai2.

Pourquoi c’est important : Cela positionne Vertex AI comme une plateforme de premier plan pour le développement d’applications d’intelligence artificielle multimodales. Les développeurs et les entreprises bénéficient d’un éventail incomparable d’options et d’outils pour travailler avec une grande variété de types de données — un avantage distinctif qui place Google Cloud en tête dans le domaine de l’IA.

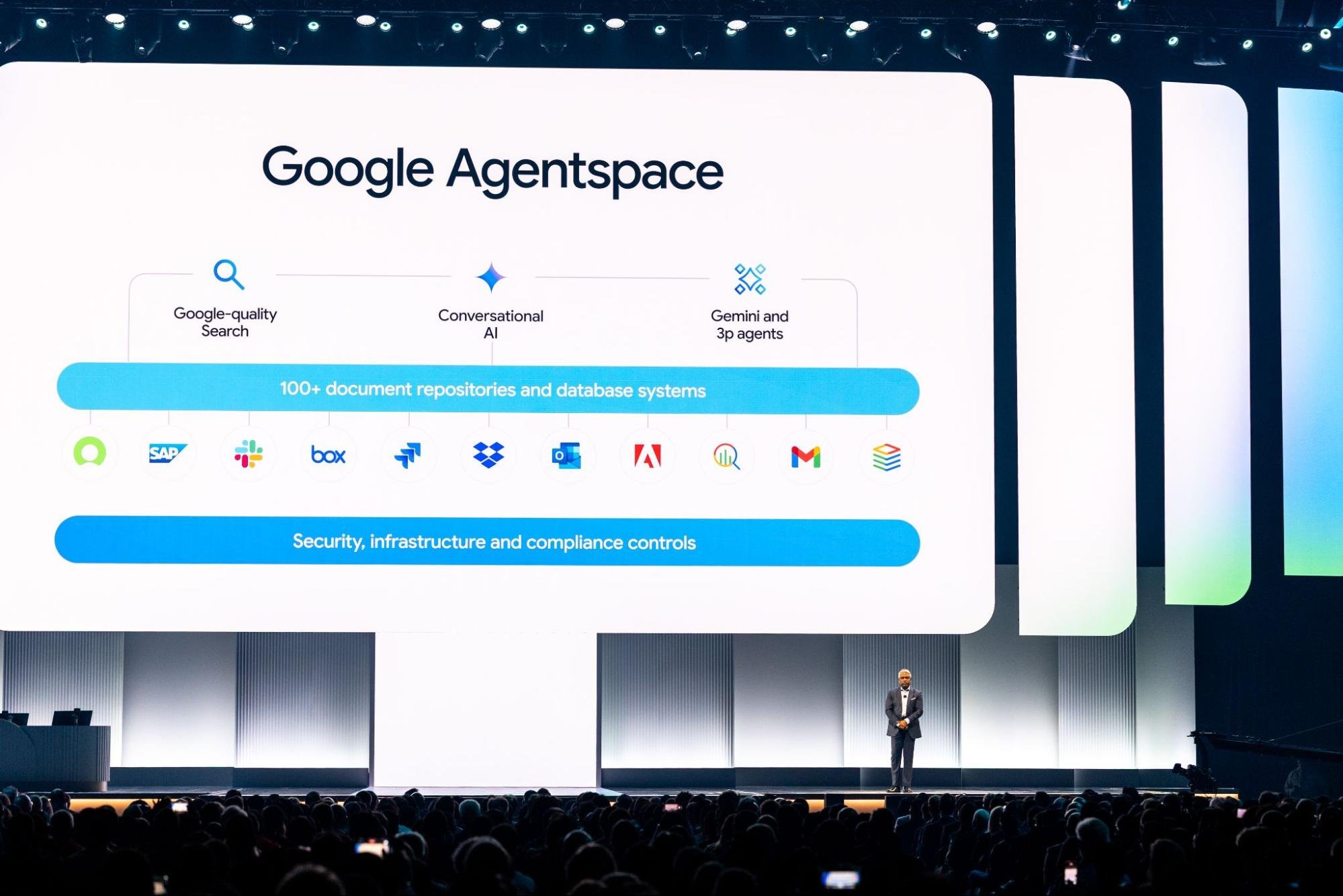

Google Cloud a également introduit kit de développement d’agents (ADK) et le protocole ouvert Agent2Agent (A2A), déjà soutenus par des dizaines de partenaires. Ces outils préparent le terrain pour la création et la gestion de systèmes complexes d’agents d’IA interactifs.

Le nouveau Agent Engine offre un environnement entièrement géré pour tester et déployer ces systèmes à grande échelle. Des outils comme Agentspace — désormais connecté à Chrome Enterprise — ainsi que UUUU et un Designer sans code, sont conçus pour aider les entreprises à déployer des agents d’IA à travers équipes et départements, mettant ainsi la puissance de l’intelligence artificielle entre les mains des utilisateurs quotidiens.

Pourquoi c’est important : Cette initiative marque un tournant clair : elle aide les entreprises non seulement à explorer l’IA, mais aussi à l’utiliser concrètement. Les standards ouverts favorisent la collaboration au sein de la communauté, tandis que les services gérés et les outils conviviaux abaissent les barrières à l’entrée.

Cela signifie que davantage d’organisations peuvent exploiter l’IA pour des travaux à fort impact, comme la recherche, la stratégie et l’innovation — sans avoir besoin d’une équipe d’ingénieurs dédiée.

Source : cloud.google.com

L’infrastructure de l’intelligence artificielle

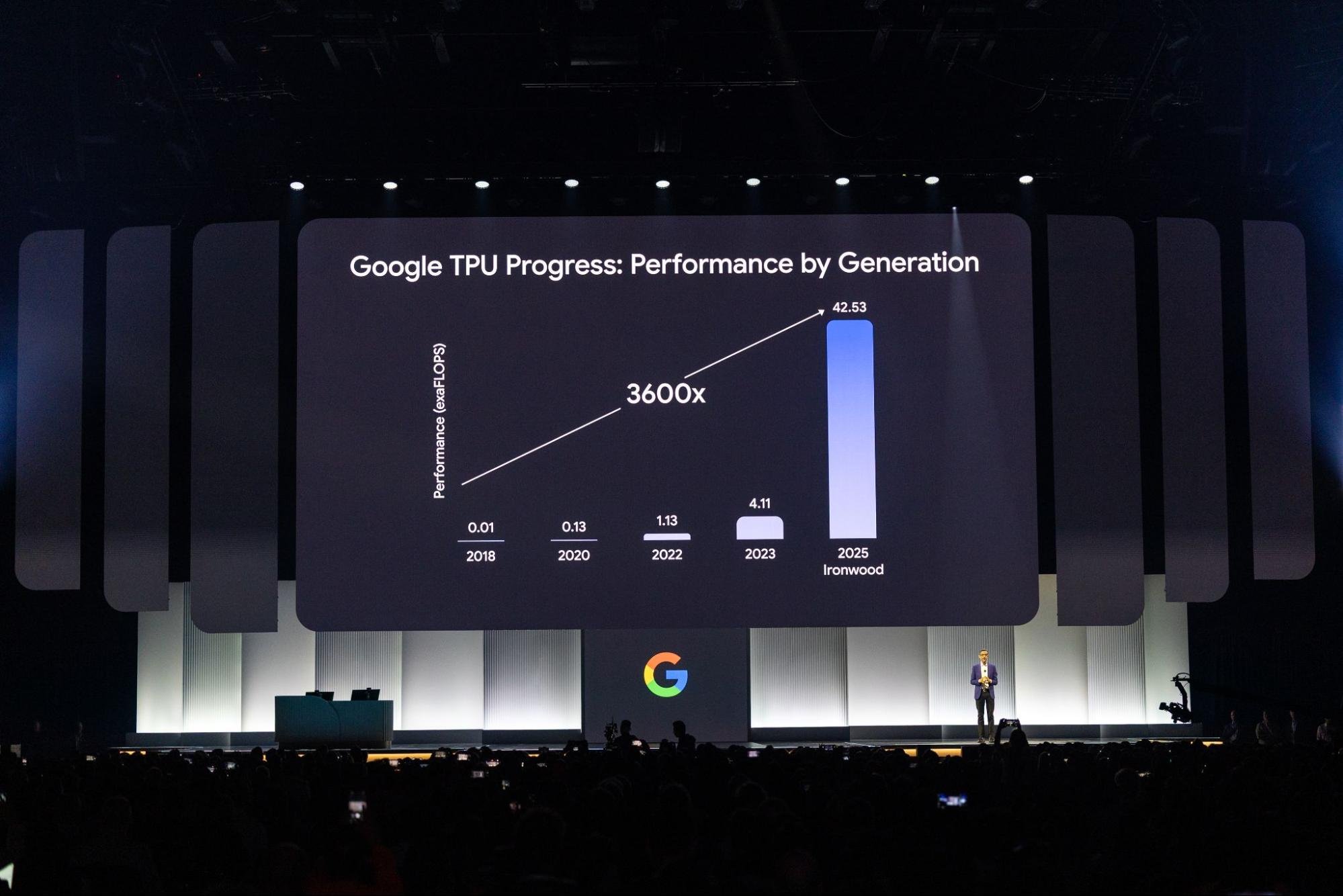

L’arrivée prochaine d’Ironwood (la TPU de 7e génération de Google) et le lancement des machines virtuelles A4 et A4X, équipées des GPU Blackwell (B200 et GB200) de NVIDIA, illustrent la volonté de Google Cloud de rester à la pointe dans l’innovation matérielle liée à l’IA.

Google Cloud a été le premier fournisseur majeur à proposer ces GPU Blackwell et est déjà sur les rangs pour être l’un des premiers à proposer les puces Vera Rubin de NVIDIA. Pour la première fois, les clients ont également accès à Pathways on Cloud, l’environnement d’exécution distribué de DeepMind, conçu pour gérer des modèles d’IA complexes et de grande taille.

Pourquoi c’est important : Ces mises à jour offrent aux utilisateurs une puissance de calcul et une efficacité massives pour l’entraînement et l’exécution de modèles à grande échelle. C’est essentiel pour répondre à la demande croissante de puissance de calcul pour l’IA. Et en arrivant tôt sur le marché avec des GPU NVIDIA de premier plan, Google Cloud ajoute un avantage clé pour les clients qui ont besoin de systèmes haute performance dans l’immédiat.

Google Distributed Cloud (GDC) fait équipe avec NVIDIA pour apporter les modèles Gemini aux systèmes alimentés par Blackwell, y compris ceux qui se trouvent dans des environnements sur site. Cluster Director (anciennement Hypercompute Cluster) simplifie la manière dont les entreprises déploient et gèrent des groupes d’accélérateurs, en les traitant comme un système unique et unifié.

À venir : Cluster Director pour Slurm et des fonctions d’observabilité compléte. À cela s’ajoute la prise en charge de la mise en réseau de 30 000 GPU dans une configuration non bloquante et la sécurisation RDMA avec Zero Trust, et vous obtenez un système conçu pour passer à l’échelle.

Pourquoi c’est important : L’exécution de lourdes charges de travail d’IA de ne se résume pas à la puissance brute. Ces outils aident les entreprises à déployer l’intelligence artificielle là où elles en ont besoin – sur site, hybride ou autre – tout en s’assurant que ces systèmes sont sécurisés, efficaces et plus faciles à gérer à l’échelle.

Source : cloud.google.com

Développement d’applications

Les agents Gemini Code Assist sont désormais disponibles pour gérer les tâches quotidiennes des développeurs telles que la migration du code, l’écriture de nouvelles fonctionnalités, les révisions, les tests et la documentation. Ils sont intégrés directement dans Android Studio et même dans le nouveau tableau Kanban pour faciliter le suivi des projets.

Dans Firebase Studio, un nouvel agent App Prototyping peut prendre des idées d’applications et les transformer en prototypes fonctionnels en un rien de temps.

Du côté de l’infrastructure, Gemini Cloud Assist accélère le processus de conception et de déploiement. Il aide également à résoudre les problèmes et s’intègre étroitement à l’ensemble des services Google Cloud, y compris le tout nouveau FinOps Hub 2.0.

Pourquoi c’est important : Ces assistants virtuels réduisent le temps de développement, allègent la charge des opérations et libèrent les équipes pour des travaux de plus haut niveau. En intégrant l’intelligence artificielle directement dans les outils que les développeurs utilisent déjà, Google Cloud contribue à rendre le développement d’applications plus rapide, plus fluide et plus rentable.

Le nouveau Centre de conception d’applications offre un moyen visuel et pratique de créer et de mettre à jour des modèles d’applications. Le Cloud Hub sert de tableau de bord central pour tout ce qui concerne les déploiements, la santé du système, l’optimisation des performances et l’utilisation des ressources.

App Hub regroupe plus de 20 produits Google Cloud pour donner aux équipes une vue claire de leurs environnements, axée sur les applications. Et grâce à un tout nouvel Explorateur de coûts (actuellement en avant-première privée), vous pouvez désormais analyser en détail les dépenses et les mesures d’utilisation au niveau des applications.

Pourquoi c’est important : Pour les grandes organisations qui travaillent sur des systèmes complexes, ces outils apportent une clarté indispensable. Grâce à une meilleure visibilité sur la façon dont les applications sont conçues, exécutées et facturées, les équipes peuvent prendre des décisions de gouvernance plus éclairées.

Firebase s’impose comme une plateforme de choix pour les développeurs qui créent des applications alimentées par l’IA, avec un nouvel ensemble d’outils visant à accélérer le développement et à améliorer la qualité. Le nouveau Firebase Studio est un espace de travail basé sur le cloud et axé sur l’IA, construit autour de la plateforme Gemini.

Il est conçu pour aider les développeurs à créer et à livrer rapidement des applications d’IA complètes et prêtes à être produites. Les agents Gemini Code Assist sont directement intégrés ; de plus, Firebase prend désormais en charge l’API Live pour les modèles Gemini via Vertex AI, ce qui permet de disposer de capacités de conversation en temps réel au sein même de vos applications.

Pourquoi c’est important : Firebase Studio réunit tout ce qui est nécessaire pour créer rapidement des applications modernes basées sur l’IA. Avec l’intégration de Gemini à chaque étape et la prise en charge des interactions dynamiques en direct, il est plus facile que jamais de créer des expériences utilisateur attrayantes.

Sur le plan de la qualité, un nouvel agent App Testing dans Firebase App Distribution (actuellement en avant-première) aide à préparer les applications mobiles au lancement en générant et en exécutant automatiquement des tests complets de bout en bout.

Entre-temps, Firebase App Hosting est désormais disponible de manière générale. Il offre un flux de travail basé sur Git, adapté à la construction et au déploiement d’applications web complètes.

Pourquoi c’est important : Ces ajouts aident les développeurs à détecter les problèmes plus tôt, à améliorer la stabilité des applications et à livrer les mises à jour plus rapidement. L’hébergement est étroitement intégré et les opinions sont bien exprimées, ce qui est parfait pour les équipes qui veulent se concentrer sur le développement sans avoir à se préoccuper de l’infrastructure.

Cloud Run & SaaS Runtime

Les GPU Cloud Run sont désormais entièrement disponibles, ce qui vous permet d’exécuter des charges de travail intensives en GPU dans une configuration sans serveur. De plus, l’aperçu public des déploiements multi-régions pour Cloud Run renforce la résilience des applications, et un aperçu privé des pools de travailleurs pour les consommateurs Kafka ajoute la prise en charge des charges de travail basées sur la traction.

Dans le même temps, SaaS Runtime offre une solution complète de gestion du cycle de vie pour aider les fournisseurs de SaaS à modéliser, déployer et exploiter leurs services avec peu ou pas d’effort, avec des outils intégrés pour ajouter rapidement des capacités d’intelligence artificielle.

Pourquoi c’est important : Ces mises à jour étendent les capacités de Cloud Run, ce qui en fait un choix solide pour les applications exigeantes et critiques, telles que l’IA et l’inférence ML, tout en améliorant la fiabilité et la prise en charge des architectures événementielles. En retour, SaaS Runtime réduit les problèmes de développement et d’exploitation.

Calcul

Les nouvelles machines virtuelles C4D, alimentées par les processeurs AMD EPYC et l’architecture Titanium personnalisée de Google, offrent des performances jusqu’à 30 % supérieures à celles des générations précédentes.

Les machines virtuelles C4, réalisées sur les puces Granite Rapids d’Intel, vont encore plus loin avec les vitesses d’horloge les plus élevées de toutes les machines virtuelles Compute Engine (jusqu’à 4,2 GHz) et des performances SSD locales plus rapides.

Pour les utilisations HPC intensives, les machines virtuelles H4D offrent une performance de premier ordre par nœud et par cœur, ainsi qu’une bande passante mémoire de premier plan.

Pourquoi c’est important : Ces machines virtuelles offrent une plus grande flexibilité aux clients. Que vous fassiez des simulations intensives, que vous optimisiez des processus lourds en E/S ou que vous ayez simplement besoin d’un calcul général fiable, ces nouvelles familles offrent les performances dont vous avez besoin, sans trop dépenser.

Google Cloud introduit également de nouvelles machines virtuelles conçues pour répondre aux besoins spécifiques des entreprises. La série M4, certifiée pour les déploiements critiques de SAP HANA, offre un rapport prix/performances jusqu’à 65 % supérieur.

La famille Z3, axée sur les charges de travail lourdes en termes de stockage, comprend désormais des formes plus grandes et des disques SSD Titanium, ainsi que des options bare-metal pouvant atteindre 72 To.

En outre, l’adaptateur ML Titanium intègre les cartes d’interface réseau NVIDIA ConnectX-7 pour offrir une bande passante GPU-GPU de 3,2 Tbit/s. Les processeurs de délestage Titanium connectent ces cartes d’interface GPU-GPU à la carte d’interface réseau NVIDIA ConnectX-7. Les processeurs de déchargement Titanium connectent ces clusters de GPU à Jupiter, la structure de centre de données à grande vitesse de Google.

Pourquoi c’est important : Ces machines virtuelles spécialisées sont conçues pour les tâches qui ne tolèrent aucun ralentissement. Qu’il s’agisse de bases de données d’entreprise ou d’entraînement de modèles d’IA à grande échelle, elles sont optimisées pour la vitesse, la fiabilité et les performances. La famille Titanium mise à jour, en particulier, aide à prendre en charge les mouvements de données massifs et l’évolutivité qu’exige l’intelligence artificielle moderne.

Conteneurs et Kubernetes

- GKE Inference Gateway ajoute une mise à l’échelle intelligente et un équilibrage de charge adaptés aux modèles d’intelligence artificielle générative.

- GKE Inference Quickstart automatise la mise en place de votre infrastructure d’intelligence artificielle.

- RayTurbo on GKE, réalisé avec Anyscale, accélère le traitement des données de 4,5 fois et réduit de moitié les besoins en nœuds.

Pourquoi c’est important : Ces outils simplifient le déploiement et la gestion des charges de travail d’inférence, vous permettant de déployer des modèles d’IA à grande échelle tout en économisant du temps et de l’argent. Les gains d’efficacité majeurs de RayTurbo sont particulièrement précieux pour les pipelines gourmands en données.

- Cluster Director pour GKE (maintenant GA) vous permet de traiter de grandes flottes de machines virtuelles alimentées par le GPU comme une seule unité facile à gérer.

- GKE Autopilot vient d’accélérer la planification et la mise à l’échelle des pods. Sa plateforme de calcul optimisée pour les conteneurs sera bientôt disponible pour les clusters GKE standard.

Pourquoi c’est important : Ces mises à jour augmentent les performances, améliorent les opérations et réduisent les coûts, ce qui est essentiel pour les gros travaux d’IA et autres charges de travail exigeantes. L’Autopilot plus rapide et plus intelligent fait de Kubernetes managé une option encore plus convaincante pour les équipes, quelle que soit leur taille.

Les clients

Google Cloud a mis en avant des centaines de nouveaux témoignages de clients du monde entier, montrant comment des organisations diverses mettent en œuvre ses outils d’IA.

- Bending Spoons traite un volume impressionnant de 60 millions de photos par jour avec Imagen 3.

- DBS a réduit les délais de traitement des appels de 20 % grâce à la Customer Engagement Suite.

- La DETR du Nevada utilise BigQuery et Vertex AI pour alimenter un assistant d’appel qui aide les arbitres à approuver les prestations quatre fois plus rapidement.

- Mercado Libre a lancé Vertex AI Search dans trois pays pilotes, aidant 100 millions d’ utilisateurs à trouver des produits plus rapidement et générant des millions de revenus supplémentaires.

- Spotify utilise BigQuery pour personnaliser les expériences de plus de 675 millions utilisateurs dans le monde.

- Verizon améliore le service client pour plus de 115 millions de connexions grâce aux outils d’IA de Google Cloud, notamment l’assistant de recherche personnel.

- Wayfair met à jour les attributs des produits cinq fois plus vite grâce à Vertex AI.

Pourquoi c’est important : Ces histoires ne sont pas seulement impressionnantes, elles prouvent à quel point l’intelligence artificielle de Google Cloud est largement adoptée. Qu’il s’agisse d’accélérer les opérations, de stimuler la créativité, d’améliorer le service client ou d’augmenter le chiffre d’affaires, les entreprises obtiennent des résultats concrets. Il est clair que l’IA n’est plus un simple mot à la mode, c’est un outil qui change le fonctionnement des secteurs d’activité.

Bases de données

AlloyDB AI prend désormais en charge les requêtes en langage naturel sur des données structurées, ce qui permet aux développeurs d’utiliser l’anglais simple en complément du langage SQL. Il intègre également une recherche vectorielle améliorée avec un reranking par attention croisée, des embeddings multimodaux et un nouveau modèle Gemini Embedding offrant une compréhension plus riche du texte.

En outre, la boîte à outils MCP pour les bases de données facilite la connexion des agents d’IA directement aux systèmes de données de l’entreprise.

Pourquoi c’est important : Ces mises à jour permettent d’éliminer la barrière entre les utilisateurs et leurs données. La prise en charge du langage naturel permet à un plus grand nombre de personnes d’accéder aux bases de données, et une meilleure recherche vectorielle améliore les performances des tâches d’IA telles que la correspondance sémantique. La possibilité de relier des agents d’intelligence artificielle à des bases de données est un élément clé pour la création d’outils d’entreprise plus intelligents.

Firestore offre désormais une compatibilité avec MongoDB avec une réplication multirégionale, une forte cohérence et un SLA de 99,999 %, offrant ainsi aux développeurs une interface familière avec une fiabilité de niveau professionnel.

Google Cloud a également élargi son offre Oracle avec le nouveau service Oracle Base Database Service et la disponibilité générale d’Oracle Exadata X11M, offrant plus de flexibilité et de contrôle pour les charges de travail Oracle.

Parallèlement, Database Migration Service (DMS) prend désormais en charge les migrations de SQL Server vers PostgreSQL, et le nouveau Database Center, désormais disponible en générale, offre un plan de contrôle centralisé, piloté par l’IA, pour gérer les flottes de bases de données dans tous les domaines.

Pourquoi c’est important : Ces mises à jour sont une grande victoire pour les entreprises. Qu’il s’agisse de migrer à partir de systèmes existants ou d’optimiser des charges de travail critiques, les équipes disposent désormais de plus d’options, de meilleures performances et de trajectoires plus claires. La compatibilité avec MongoDB fait de Firestore un choix incontournable pour un grand nombre de développeurs, et la prise en charge élargie d’Oracle répond à un besoin majeur pour les grandes organisations.

Source : cloud.google.com

Analyse des données

BigQuery continue d’évoluer pour devenir une plateforme véritablement autonome, alliant analytique et intelligence artificielle de bout en bout. Au cœur de cette évolution se trouve le moteur de connaissances BigQuery, qui utilise Gemini pour comprendre les relations entre les schémas, modéliser les données et même suggérer des termes de glossaire.

Parallèlement, le nouveau moteur de requêtes BigQuery AI peut traiter des données structurées et non structurées, en s’appuyant sur les connaissances et le raisonnement du monde réel de Gemini. Une multitude de nouvelles fonctionnalités, telles que les pipelines intégrés, la préparation des données, la détection des anomalies, la recherche sémantique et l’analyse de contribution, sont désormais disponibles en général ou en avant-première.

Pourquoi c’est important : Ces mises à jour intègrent l’intelligence artificielle directement dans le flux de données, ce qui permet aux utilisateurs de passer des données brutes aux informations plus rapidement que jamais. Qu’il s’agisse de repérer des anomalies, de préparer des données ou de poser des questions complexes, BigQuery vous aide désormais à le faire de manière plus intuitive et avec moins de travail manuel.

BigQuery prend également en charge les tables multimodales, traitant les données non structurées comme des éléments de première classe.

Le Universal Catalog (anciennement Dataplex Catalog) offre une couche de métadonnées unifiée, avec une interopérabilité du metastore entre les moteurs, ainsi qu’ un glossaire métier pour une meilleure gouvernance.

Les nouvelles requêtes continues permettent une analyse quasi instantanée des données en streaming, tandis que la reprise après sinistre managée – désormais disponible en générale – offre un basculement automatique et une réplication en temps quasi réel pour que les données restent protégées et disponibles.

Pourquoi c’est important : Ces mises à jour renforcent la capacité de BigQuery à s’adapter aux environnements d’entreprise complexes. Qu’il s’agisse d’analyses en temps réel, de support d’un écosystème ouvert, de gouvernance stricte ou de résilience face aux sinistres, BigQuery est désormais encore mieux équipé pour gérer des charges de travail critiques à grande échelle.

Looker bénéficie également d’une mise à jour majeure, avec de nouvelles fonctionnalités qui rapprochent l’intelligence économique des utilisateurs quotidiens. L’analyse conversationnelle (actuellement en avant-première) permet aux utilisateurs d’explorer les données en posant simplement des questions en langage naturel.

Gemini dans Looker alimente désormais des fonctionnalités telles que l’assistant de visualisation, l’assistant de formule et l’analyse conversationnelle, disponibles pour tous les utilisateurs de Looker. Il existe même un interprète de code qui gère des tâches telles que la prévision et la détection d’anomalies, sans qu’il soit nécessaire d’avoir des connaissances en Python.

Pourquoi c’est important : Cela abaisse la barre de l’analyse des données, en mettant des informations puissantes à la disposition de tous les employés de l’entreprise, et pas seulement des équipes chargées des données. C’est un grand pas vers une plus grande maîtrise des données et une prise de décision plus rapide et plus sûre.

Google Workspace : Une productivité alimentée par l’IA

- Google Sheets intègre désormais la fonction Help me Analyze, qui extrait intelligemment des informations de vos données sans que vous ayez à le demander.

- Dans Docs, Audio Overview transforme les documents en résumés audio ou podcast clairs et naturels.

- Enfin, Google Workspace Flows automatise les tâches quotidiennes telles que la gestion des approbations, la recherche d’informations sur les clients et la synthèse des courriers électroniques.

Pourquoi c’est important : Ces outils alimentés par l’IA sont intégrés aux applications que vous utilisez tous les jours. Ils vous aident à travailler plus intelligemment, à faire émerger des informations et à réduire les tâches répétitives. Le résultat ? Des gains de productivité importants et une nouvelle façon pour les équipes d’interagir avec leurs données et leurs documents.

Réseau

Google Cloud fait évoluer son infrastructure afin de répondre aux exigences extraordinaires des plus grands modèles d’IA actuels et des services qu’ils alimentent.

La nouvelle prise en charge réseau pour un maximum de 30 000 GPU par cluster dans une configuration entièrement non bloquante, associée à la sécurité RDMA Zero-Trust et un réseau RDMA GPU-to-GPU ultra-rapide de 3,2 Tbps, élimine un obstacle majeur aux performances.

L’introduction de 400G Cloud Interconnect et Cross-Cloud Interconnect augmente encore plus la bande passante, offrant un débit quatre fois supérieur à celui des générations précédentes.

Pourquoi c’est important : Ces mises à niveau sont essentielles pour l’entraînement et l’exécution d’énormes modèles d’IA. Avec une telle puissance de réseau, les développeurs et les entreprises peuvent construire et déployer des systèmes d’IA qui n’étaient tout simplement pas réalisables auparavant, sans craindre que l’infrastructure ne devienne un frein.

Google Cloud renforce également son infrastructure centrale pour améliorer la connectivité mondiale et la sécurité. Cloud WAN offre désormais un réseau haute performance entièrement mangé qui réduit le coût total de possession jusqu’à 40 %, tout en améliorant la vitesse et la fiabilité pour les environnements d’entreprise distribués. Du côté de la sécurité, les mises à jour comprennent :

- DNS Armor, qui détecte les tentatives d’exfiltration de données.

- Politiques hiérarchiques dans Cloud Armor pour des contrôles de sécurité plus précis.

- Cloud NGFW avec filtrage des domaines de la couche 7.

- DLP réseau en ligne, offrant une protection en temps réel des données sensibles en transit.

Pourquoi c’est important : Que vous gériez une configuration hybride ou une mise à l’échelle sur plusieurs clouds, ces fonctionnalités aident les entreprises à rester rapides, connectées et sécurisées. Les gains en performance et le renforcement de la sécurité sont essentiels pour protéger les applications modernes contre des menaces de plus en plus complexes.

Source : cloud.google.com

Sécurité

Google Unified Security regroupe tout en un seul endroit : visibilité, détection des menaces, opérations de sécurité pilotées par l’IA, tests d’intrusion virtuels en continue, navigateur d’entreprise et savoir-faire de Mendiant.

Deux nouveaux agents d’IA change la donne : l’agent de triage des alertes analyse les notifications, enquête en temps réel, rassemble le contexte et pose un diagnostic sur la situation.

L’agent d’analyse des malwares, quant à lui, examine le code suspect et peut même exécuter des scripts pour déchiffrer des menaces complexes et dissimulées.

Pourquoi c’est important : Cette configuration tout-en-un, alimentée par une automatisation intelligente, facilite le travail des équipes de sécurité, accélère la détection des menaces et améliore la précision de leur traitement, tout en réduisant le travail manuel.

Le programme de protection des risques (pensez à une cyber-assurance à prix réduit) inclut désormais de nouveaux partenaires tels que Beazley et Chubb, offrant ainsi plus d’options aux entreprises.

Le service Mandiant Retainer offre un accès à la demande aux meilleurs experts lorsque des enquêtes ou des informations sur les menaces sont nécessaires. Par ailleurs, les partenariats de Mandiant Consulting avec Rubrik et Cohesity aident les entreprises à rebondir plus rapidement en réduisant les temps d’arrêt et les coûts de reprise après une attaque.

Pourquoi c’est important : Ensemble, ces solutions rendent les cyber-risques moins intimidants, offrant aux entreprises une protection financière solide et le soutien d’experts lorsqu’elles en ont le plus besoin.

Stockage

Les pools de stockage Hyperdisk ont été multipliés par cinq pour atteindre 5 PiB, tandis que les tout nouveaux Exapools Hyperdisk offrent le plus grand et rapide stockage par blocs disponible dans n’importe quel cloud public – pensez à des exaoctets de capacité et à des téraoctets par seconde de vitesse.

Ensuite, il y a Rapid Storage, un nouveau bucket de stockage cloud zonal avec une latence fulgurante de lecture/écriture aléatoire inférieure à 1 ms, un accès aux données 20 fois plus rapide, et un débit atteignant 6 To/s. Anywhere Cache réduit la latence jusqu’à 70 % en rapprochant les données des GPU et des TPU, accélérant ainsi les traitements liés à l’intelligence artificielle.

De plus, Google Cloud Managed Lustre propose un système de fichiers parallèle entièrement géré, à haute performance, capable de gérer des charges de travail à l’échelle du pétaoctet avec une latence ultra-faible et des millions d’IOPS (opérations d’entrée/sortie par seconde).

Pourquoi c’est important: Ces avanées éliminent les goulets d’étranglement des données qui peuvent ralentir la formation et l’inférence de l’IA, en offrant ainsi d’énormes améliorations en termes de vitesse de stockage, de taille et de réactivité. Le résultat ? Des gains considérables en vitesse, en capacité et en réactivité du stockage.

Google Cloud a également lancé Storage Intelligence, le premier service utilisant des grands modèles de langage pour analyser les métadonnées des objets à grande échelle et fournir des informations spécifiques à l’environnement.

Pourquoi c’est important : Cela permet aux équipes de mieux gérer leur stockage grâce à une visibilité claire et un meilleur contrôle sur d’importants volumes de données, facilitant les décisions sur le placement, la réduction des coûts et la conformité.

Startups

Google Cloud renforce son soutien aux startups en phase de démarrage, en particulier celles qui se concentrent sur l’intelligence artificielle. Grâce à un partenariat majeur avec Lightspeed, les entreprises du portefeuille IA peuvent désormais obtenir jusqu’à 150 000 dollars de crédits cloud, en plus de ce qui est déjà disponible dans le cadre du programme Google Cloud for Startups.

En outre, les startups obtiennent 10 000 dollars de crédits supplémentaires spécifiquement pour les modèles partenaires via Vertex AI Model Garden, encourageant ainsi l’expérimentation pratique avec les modèles d’IA d’Anthropic, de Meta et d’autres encore. Le nouveau programme Startup Perks ouvre également les portes à des solutions privilégiées de partenaires tels que Datadog, Elastic et GitLab.

Pourquoi c’est important : Ces initiatives permettent aux startups de construire et de se développer plus facilement sur Google Cloud. En offrant des crédits généreux, des outils de partenariat et une variété de modèles d’IA, Google Cloud contribue à alimenter l’innovation et à consolider sa place en tant que plateforme de choix pour les entreprises technologiques en plein essor.

À propos de nous

En tant que partenaire principal de confiance de Google Cloud, Cloudfresh a permis à plus de 200 000 professionnels dans plus de 70 pays de renforcer leurs compétences. Nos services de conseil Google Cloud vous mettent en relation avec une équipe d’experts certifiés maîtrisant parfaitement les outils, les technologies et les meilleures pratiques de Google Cloud, ce qui vous permet de vous concentrer sur votre cœur de métier tout en maximisant la valeur de votre investissement dans le cloud.