Ces tendances de l’IA et de l’apprentissage automatique impactant les entreprises en 2024

L’analyse des données d’IA sur Google Cloud Platform et son coût

- L’analyse de données IA : cas d’usage

- Vertex AI

- Gemini : l’IA générative au service de l’analyse de données

- À propos de nous

Dans l’article d’aujourd’hui, nous décortiquerons la structure des coûts de l’analyse de données par l’IA sur Google Cloud Platform (GCP), l’un des premiers fournisseurs d’infrastructures cloud en termes de parts de marché.

Tout d’abord, il convient de noter que sur toutes les ressources officielles de Google Cloud, l’intelligence artificielle (IA) et le machine learning (ML) sont indissociables et réunis en une seule et même catégorie.

Le nombre de produits connexes varie de 17 à 27, preuve que Google élargit sans cesse sa gamme pour répondre au besoin croissant de nouvelles fonctionnalités.

Nous nous concentrerons sur la tarification de deux produits phares de GCP, à savoir Vertex AI et Gemini, ainsi que sur les outils d’analyse IA tels que BigQuery et Looker.

En tant que Partenaire Premier Google Cloud mondial, nous répondrons aux questions suivantes de la manière la plus exhaustive possible :

- Le stockage des données d’entraînement pour la recherche d’architecture neuronale dans BigQuery est-il aussi coûteux que l’exécution de Vertex AI NAS elle-même ?

- Combien coûte l’utilisation de BigQuery en tant que dépôt de features hors ligne pour le machine learning (Vertex AI Feature Store) ?

- Combien coûte votre tranquillité d’esprit ? Le coût associé au suivi des modèles Vertex AI avec les données d’entraînement et de prédiction stockées dans BigQuery.

- L’abonnement à Gemini Code Assist en vaut-il la peine ? Vous obtiendrez un aperçu exclusif de l’analyse conversationnelle dans Looker et de l’optimisation des coûts dans BigQuery.

Débutons sans plus attendre !

L’analyse de données IA : cas d’usage

Chacun des cas d’utilisation ci-dessous prouve que des entreprises de secteurs très différents exploitent les outils d’IA de Google Cloud pour relever des défis majeurs, gagner en efficacité et bénéficier de nouvelles opportunités.

Transport et mobilité

- Geotab exploite BigQuery et Vertex AI pour traiter chaque jour des milliards de points de données de plus de 4,6 millions de véhicules. Cela permet une gestion de flotte plus intelligente, une conduite plus sûre, la décarbonisation des transports et des informations permettant aux villes de devenir plus sûres et plus durables.

Finance et assurance

- Dojo traite des millions de paiements sécurisés et ultra-rapides chaque jour. Grâce aux modèles Looker et Gemini, l’entreprise teste de nouvelles manières pour les entreprises d’interagir naturellement avec les informations de paiement.

- United Wholesale Mortgage révolutionne le processus de prêt immobilier avec Vertex AI, Gemini et BigQuery. En seulement neuf mois, l’entreprise a doublé la productivité de ses souscripteurs, réduisant ainsi les délais de clôture des prêts pour 50 000 courtiers et leurs clients.

- Hiscox a développé le premier modèle de souscription de leads alimenté par l’IA pour les assureurs grâce à BigQuery et Vertex AI. Les devis pour des risques complexes qui prenaient autrefois trois jours sont désormais réalisés en quelques minutes.

- MSCI, leader dans la publication d’indices et d’indicateurs de marché, exploite Vertex AI, BigQuery et Cloud Run pour enrichir les informations sur près d’un million de localisations d’actifs. Ces données, basées sur l’analyse IA, aident les clients à mesurer et à gérer les risques liés au climat.

- Apex Fintech Solutions s’appuie sur BigQuery, Looker et Google Kubernetes Engine pour élargir l’accès aux informations financières, démocratiser l’investissement et se préparer à l’innovation pilotée par l’IA.

- 180 Seguros a amélioré sa plateforme de données interne avec l’IA de Google Cloud et BigQuery. Les employés suivent désormais les métriques opérationnelles et les requêtes s’exécutent trois fois plus vite.

- Aluga Mais, une start-up de location brésilienne, exploite Vertex AI, Document AI et BigQuery pour établir les profils financiers de ses clients. Elle a ainsi réduit son temps d’analyse des dossiers d’inscription à seulement 24 secondes, contre 90 minutes auparavant.

Commerce de détail et biens de consommation

- Tchibo, la marque européenne de café et d’e-commerce, fait confiance à Vertex AI et BigQuery pour prévoir la demande. Sa solution d’analyse de données alimentée par l’IA, DEMON, réalise plus de six millions de prédictions par jour, aidant l’entreprise à gérer ses stocks, à réduire ses coûts logistiques et à améliorer la disponibilité de ses produits.

- Unilever a numérisé sa distribution commerciale grâce à BigQuery. L’entreprise traite désormais 75 000 commandes par jour et sert des millions de détaillants sur les marchés émergents.

- Gymshark, marque et communauté de fitness britannique, a construit une plateforme de données unifiée grâce à BigQuery, Looker, Dataflow et Vertex AI. Ce système offre des données clients plus approfondies et fournit des expériences de fitness personnalisées à grande échelle.

Santé

- ARC Innovation au Centre Médical Sheba exploite Looker Studio et BigQuery ML pour créer des solutions d’analyse de données IA qui améliorent les décisions cliniques critiques dans le traitement du cancer de l’ovaire.

Technologie et services

- Bosch SDS a placé la durabilité au cœur de ses opérations grâce à Google Cloud. En exploitant Kubernetes, BigQuery et Firebase, l’entreprise a construit un moteur cognitif piloté par l’IA qui émet des alertes en temps réel. Résultat : une réduction de 12 % des coûts énergétiques, un plus grand confort et une utilisation accrue des énergies renouvelables.

Médias et divertissement

- Spotify s’est associé à Google Cloud pour gérer ses volumes de données massifs avec BigQuery. La plateforme traite d’énormes quantités d’informations pour offrir des expériences d’écoute personnalisées à plus de 675 millions d’utilisateurs à travers le monde.

Découvrez d’autres études de cas GCP.

Vertex AI

Pour créer et gérer des modèles de machine learning sur Google Cloud, Vertex AI propose une boîte à outils complète.

Que vous vous intéressiez à la recherche d’architecture neuronale (NAS), centralisiez vos données de features avec un Feature Store, ou surveilliez la qualité des modèles avec Model Monitoring, ces outils vous permettent de concevoir, d’entraîner et de gérer efficacement des systèmes d’analyse de données IA.

Examinons de plus près le fonctionnement de chaque composant, le coût de Vertex AI et son intégration dans un flux de travail de ML concret.

Recherche d’architecture neuronale (NAS)

Vertex AI Neural Architecture Search (NAS) est un outil permettant de trouver les architectures neuronales les plus performantes. Il prend en compte ou ignore des contraintes telles que la latence, la taille de la mémoire et des métriques personnalisées.

Grâce à sa capacité à explorer un espace de recherche allant jusqu’à 10^20, NAS a contribué à la création de modèles de vision par ordinateur avancés tels que Nasnet, MNasnet, EfficientNet, NAS-FPN et SpineNet.

Toutefois, NAS n’est pas un outil prêt à l’emploi. Il requiert une équipe dédiée pour configurer et tester les paramètres architecturaux tels que la taille du noyau ou le nombre de canaux. Il est parfait lorsque les méthodes traditionnelles, comme l’ajustement des hyperparamètres, n’apportent plus d’améliorations.

NAS n’est pas recommandé si vous disposez de données limitées ou fortement déséquilibrées, car il repose sur l’expérimentation à grande échelle et la disponibilité des données.

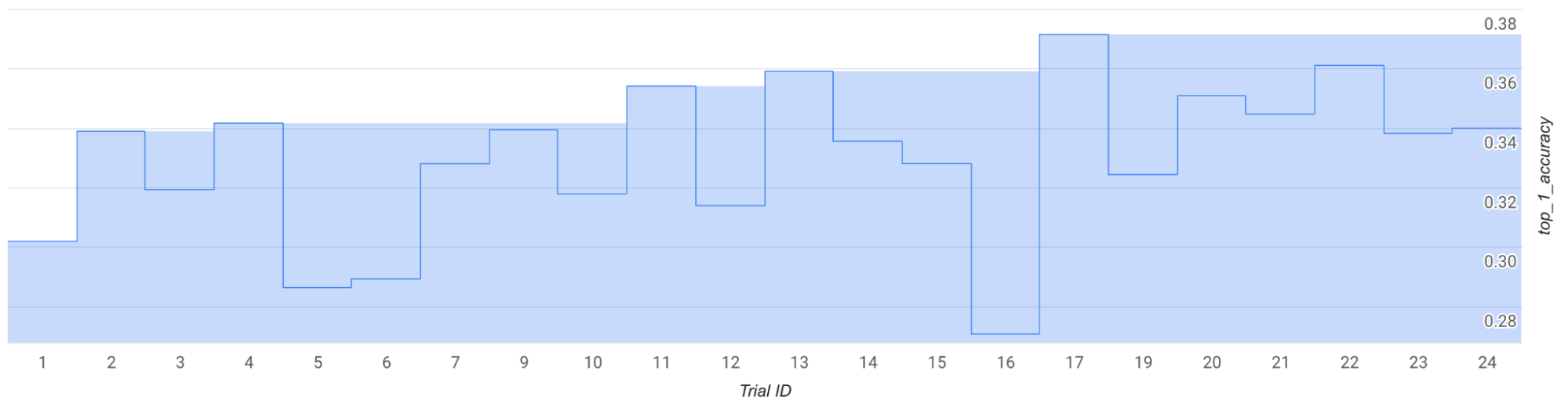

Si l’on exécute quelques tâches de test en utilisant un espace de recherche préconfiguré et l’entraîneur MNasNet, vous observerez sur le graphique que la meilleure récompense à l’étape 1 passe d’environ 0,30 à l’essai 1 à environ 0,37 à l’essai 17. Vos résultats peuvent varier légèrement en fonction de l’échantillonnage, mais vous devriez tout de même observer une augmentation.

Gardez à l’esprit qu’il ne s’agit que d’un test et non d’une preuve de concept (PoC) ou d’un benchmark public pour l’analyse de données alimentée par l’IA.

- Essais, au total : 25

- GPU par essai : 2

- Type de GPU : TESLA_T4

- CPU par essai : 1

- Type de CPU : n1-highmem-16

- Durée moyenne de l’entraînement par essai : 3 heures

- Essais en parallèle : 6

- Quota total de GPU utilisé : (nb_gpu_par_essai × nb_essais_parallèles) = 2 × 6 = 12

- Région : us-central1 (données d’entraînement stockées dans la même zone ; aucun quota supplémentaire requis)

- Temps d’exécution : (essais_totaux × temps_entraînement_par_essai) ÷ (nb_essais_parallèles) = (25 × 3) ÷ 6 = 12 heures

- Exprimé en heures-GPU : (essais_totaux × temps_entraînement_par_essai × nb_gpu_par_essai) = 25 × 3 × 2 = 150 heures T4

- Exprimé en heures-CPU : (essais_totaux × temps_entraînement_par_essai × nb_cpu_par_essai) = 25 × 3 × 1 = 75 heures n1-highmem-16

Le coût estimé s’élève à environ 185 $ US. Naturellement, libre à vous d’arrêter le processus plus tôt pour réduire vos dépenses.

La flexibilité de NAS lui confère sa puissance, mais il est coûteux. Il convient parfaitement aux entreprises prêtes à investir dans des projets de modélisation innovants à grande échelle.

Outre les machines virtuelles, les accélérateurs et les disques (selon le type et la région), vous aurez également besoin de stockage Cloud.

Le plus important ici est le coût du stockage des données d’entraînement, où BigQuery peut également être utilisé avec son propre modèle de tarification. Par exemple, vos 10 premiers Go par mois sont gratuits pour l’analyse de données IA et d’autres usages.

Intégration Vertex AI & BigQuery : Feature Store

Vertex AI Feature Store est un dépôt centralisé de gestion et de traitement des features de machine learning.

Les Feature Stores sont un élément central de l’infrastructure MLOps de bout en bout sur GCP. Ils permettent aux équipes de science des données et de ML d’accélérer les cycles de déploiement en organisant les features à l’échelle de toute l’entreprise.

Le Feature Store facilite la création, le stockage, le partage, la recherche et la fourniture des features aux applications de ML.

En outre, BigQuery peut servir de Feature Store hors ligne.

Ainsi, les entreprises peuvent conserver leur infrastructure existante, éviter la duplication des données d’analyse IA et réduire les coûts.

Les équipes peuvent également exploiter BigQuery SQL pour le feature engineering grâce à ses paramètres d’accès et de contrôle intégrés.

Puisque BigQuery est utilisé pour les opérations hors ligne, la facturation concerne des éléments comme le chargement des données, l’exécution des requêtes et le stockage des jeux de données hors ligne.

Par exemple, si vous exploitez l’API BigQuery Storage Write dans la région europe-west4 (Pays-Bas), vous bénéficiez de 2 Tio gratuits par mois. Au-delà, le tarif est de 0,03 $ US par Gio supplémentaire.

Model Monitoring (Suivi des modèles)

Vertex AI Model Monitoring vous permet d’exécuter des tâches à la demande ou planifiées pour suivre la qualité des modèles tabulaires.

Les alertes configurées vous notifient à chaque fois que les métriques dépassent les seuils prédéfinis.

Supposons que vous ayez construit un modèle d’analyse prédictive pour suivre la valeur vie client (CLV). Après le lancement d’un nouveau programme de fidélité, les features initiales peuvent ne plus refléter le comportement des clients, ce que l’on appelle la dérive des données.

Model Monitoring peut détecter cette dérive et vous alerter du dépassement de vos seuils. Il est possible que vous deviez réévaluer ou réentraîner votre modèle d’analyse de données IA.

Le tarif est de 3,50 $ US par Go de données analysées, et comprend les données d’entraînement et de prédiction stockées dans les tables BigQuery.

Des frais supplémentaires s’appliquent pour d’autres produits Google Cloud exploités avec Model Monitoring, comme le stockage BigQuery.

Exemple :

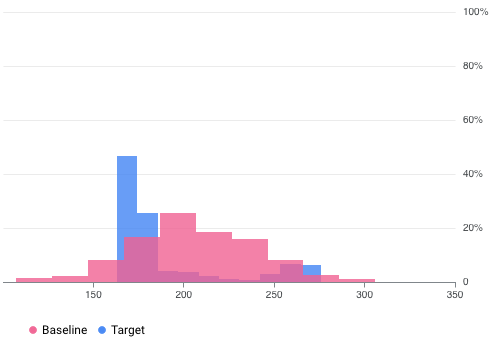

L’équipe de science des données lance le suivi d’un modèle entraîné sur des données de BigQuery. Après conversion des données d’entraînement en TfRecord, la taille est de 5,0 Go. Les données de prédiction enregistrées entre 10 h 00 et 11 h 00 totalisent 0,5 Go, et entre 16 h 00 et 17 h 00, 0,3 Go supplémentaires. Le coût total de la mise en place du suivi de modèle est de :

(5,0 × 3,5 $ US) + ((0,5 + 0,3) × 3,5 $ US) = 20,3 $ US

Les autres composants de Vertex AI compatibles avec BigQuery incluent Workbench, Deep Learning Containers, Deep Learning VM et AI Platform Pipelines. Des frais s’appliquent si vous exécutez des requêtes SQL dans un notebook spécifique (un asset de code dans BigQuery Studio).

Gemini : l’IA générative au service de l’analyse de données

Gemini ajoute une couche d’intelligence à travers BigQuery et Looker en vue d’exploiter tout le potentiel de l’IA en analyse de données.

De la simplification des requêtes complexes à l’exploration visuelle des jeux de données, en passant par la génération de rapports et de tableaux de bord à l’aide de prompts en langage naturel, Gemini permet aux équipes de travailler plus vite, à prendre des décisions plus pertinentes et à optimiser chaque flux de travail.

Examinons comment il améliore chaque plateforme et gère les opérations concrètes.

BigQuery

Gemini dans BigQuery intègre l’analyse de données IA au sein de votre entrepôt de données. Il fournit des outils intelligents pour gérer et optimiser les charges de travail tout au long de leur cycle de vie.

Gemini assiste les analystes, les ingénieurs, les data scientists et les administrateurs de bases de données avec des fonctionnalités comme la génération de code Python et SQL et la complétion automatique.

La traduction du langage naturel en SQL vous permet de construire rapidement des requêtes, d’accélérer le développement et simplifie les tests.

Gemini traduit en outre des requêtes SQL complexes en langage simple pour les rendre plus accessibles.

La recherche est améliorée grâce à des capacités sémantiques. Vous trouverez instantanément les bonnes tables, les requêtes pertinentes et pourrez les exécuter en un clic.

Lors d’une migration ou d’un changement vers Google Cloud, Gemini aide à traduire les requêtes et à réduire la configuration manuelle de l’analyse de données IA.

L’interface Data Canvas constitue un moyen d’exploration visuel. Effectuez une analyse basée sur des prompts (par exemple : « Trouver les tables de ventes à Kharkiv »), avant de pousser les résultats en production, de les exporter pour les analyser plus profondément dans BigQuery SQL, ou les partager via Looker, Looker Studio, Google Sheets ou Google Slides.

Gemini aide également à optimiser les coûts liés au cloud et aux performances à chaque étape du pipeline de données. Ceci se répercute sur les flux de travail en aval, que ce soit pour les tableaux de bord, des modèles de ML ou des applications d’analyse de données IA.

Les pipelines d’analyse de données serverless sur Spark en bénéficient également, sans se limiter a SQL ou Python, pour détecter et corriger rapidement les erreurs.

Looker : analyse conversationnelle

Gemini dans Looker facilite la génération de rapports avec graphiques, titres, thèmes et mises en page, le tout à partir d’un simple prompt.

Résultat : vous obtenez un rapport de base que vous pouvez ensuite ajuster en langage naturel. Il agit comme votre consultant Looker intégré !

L’assistant avancé peut en outre générer du code JSON pour fournir des visualisations personnalisées, pour une création et une modification des graphiques plus rapide.

Autre fonctionnalité utile : la génération automatique de diapositives. Les rapports d’analyse de données IA peuvent être exportés vers Google Slides assortis d’explications textuelles qui mettent en évidence les données essentielles.

Vous pouvez même créer des champs calculés sans mémoriser de formules complexes, pour une analyse ad hoc bien plus simple.

Tarification

L’ensemble des fonctionnalités de Gemini dans BigQuery est disponible via l’abonnement Gemini Code Assist Standard. Le tarif est de 22,80 $ US par utilisateur et par mois, ou 19,00 $ US par utilisateur et par mois avec un engagement de 12 mois.

Ces fonctionnalités sont aussi accessibles dans les abonnements BigQuery Enterprise, Enterprise Plus et On-Demand Compute. Le prix exact varie en fonction des heures et de la région.

Toutes les options ci-dessus sont en outre soumises à des quotas spécifiques.

L’utilisation de Gemini dans Looker est actuellement gratuite, bien que cela puisse changer à tout moment.

À propos de nous

En tant que Partenaire Premier, Cloudfresh fournit des services de conseil Google Cloud de premier ordre et aide les entreprises à tirer le meilleur parti de l’IA pour l’analyse de données.

Qu’il s’agisse d’obtenir des flux de travail plus intelligents avec Gemini, d’entraîner et de déployer des modèles sur Vertex AI, d’exploiter les données dans BigQuery ou de donner vie aux insights avec Looker, vous bénéficiez d’une solution adaptée aux besoins réels de votre entreprise.

De la stratégie à la mise en œuvre, l’équipe de Cloudfresh conçoit des systèmes évolutifs, sécurisés et rentables, afin que vous puissiez avancer plus rapidement, prendre des décisions plus pertinentes et générer une valeur durable grâce aux cas d’utilisation de Google Cloud GenAI qui s’adaptent à votre modèle et vos objectifs.

N’hésitez pas à remplir le court formulaire ci-dessous pour vous lancer et en savoir plus !